La IA como herramienta al nuevo desafío agroalimentario

Durante décadas, el sector agroalimentario aprendió a convivir con la incertidumbre, hoy debe operar dentro de ella de forma permanente. Agua más escasa, clima más…

Ver, oír y reconocer un rostro solía bastar para asumir que algo era real. Hoy, la inteligencia artificial puede fabricar vídeos, voces e imágenes indistinguibles de la realidad, trasladando la carga de la verificación a las personas. El riesgo ya no es solo la manipulación puntual, sino la erosión estructural de la confianza, donde el daño social, reputacional o económico se produce antes de que el engaño pueda ser desmentido.

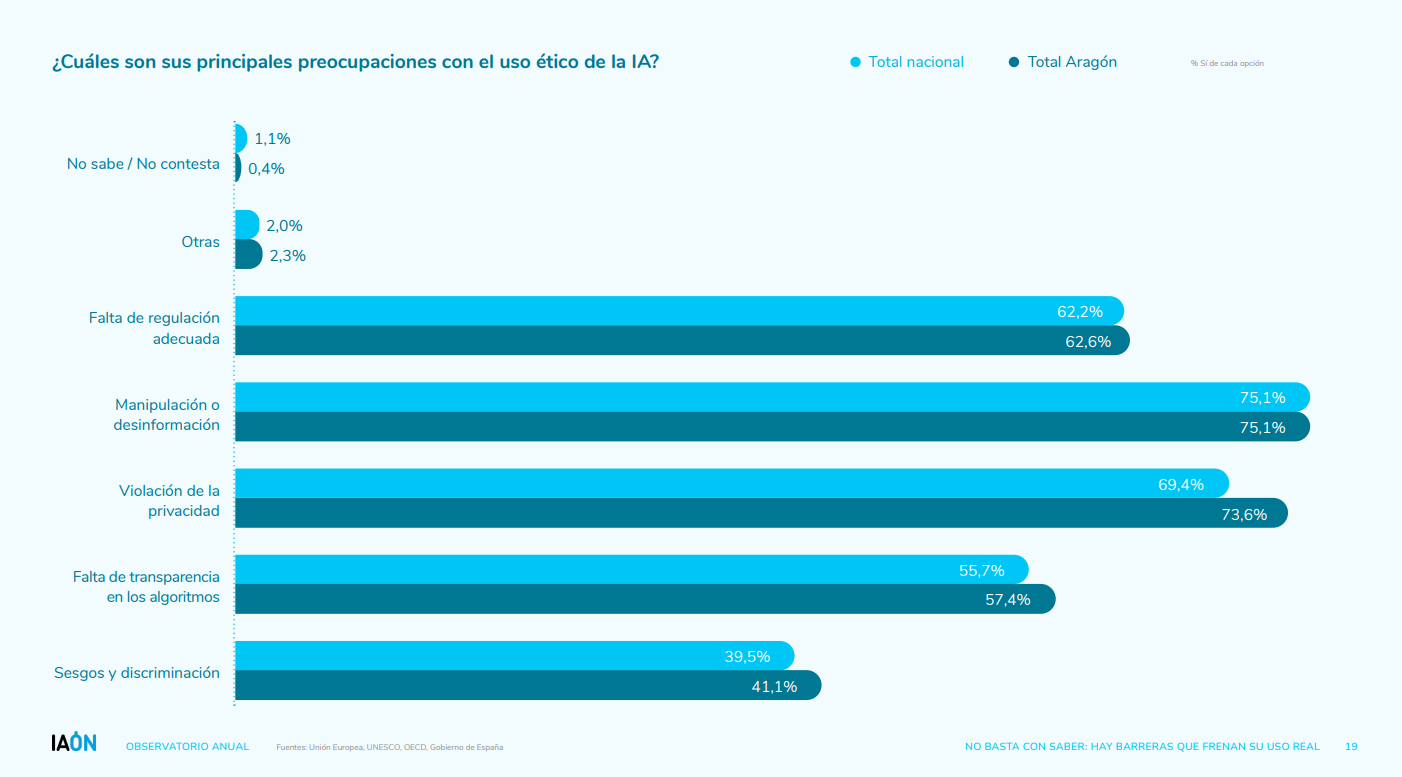

En los últimos años, el avance de la inteligencia artificial ha impulsado logros notables en múltiples ámbitos, desde la automatización de procesos hasta la creación de nuevos contenidos digitales. Sin embargo, junto a estos beneficios han emergido preocupaciones éticas cada vez más visibles, especialmente en torno a la manipulación y la desinformación. Las encuestas reflejan que estas inquietudes no son marginales.

En la última encuesta realizada en nuestro Observatorio Anual se determinó que el 75,1 % de los encuestados consideraba que la capacidad de la IA para generar y amplificar contenidos falsos representa una amenaza real. Este temor va más allá de las tradicionales fake news y apunta a un escenario más profundo, en el que la automatización de la manipulación informativa puede erosionar la confianza en los medios, las instituciones y los propios procesos democráticos.

Fuente: IAON

Dentro de este contexto, los deepfakes emergen como uno de los principales catalizadores de estas preocupaciones, a medida que la inteligencia artificial se integra en más aspectos de la vida cotidiana. El término deepfake[1] surge de la combinación de deep learning (aprendizaje profundo) y fake (falso), y hace referencia a imágenes, vídeos o audios generados o manipulados mediante IA para imitar de forma realista el rostro, la voz o los movimientos de una persona.

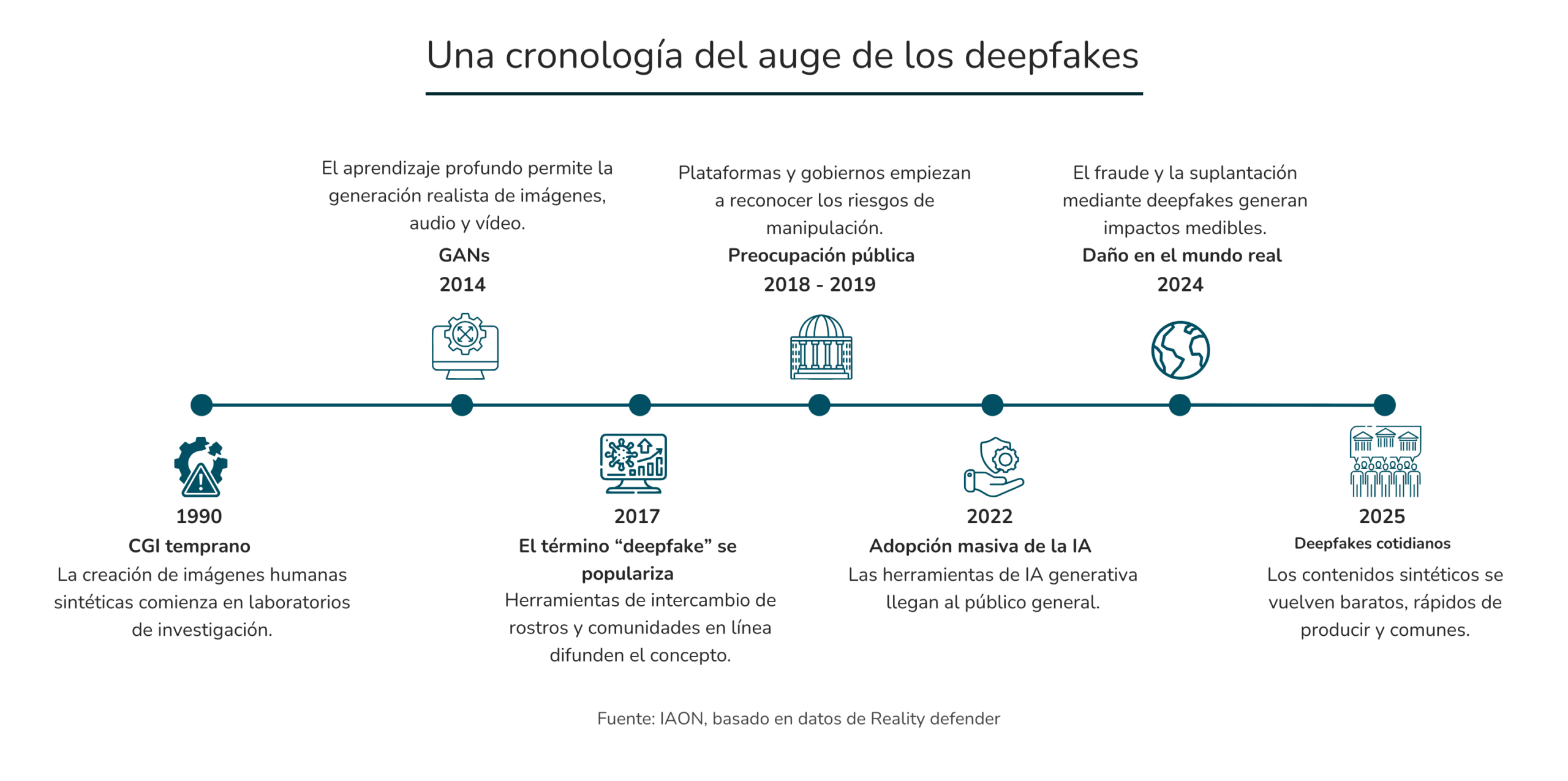

Aunque esta tecnología tiene su origen en los años noventa, cuando la investigación en gráficos por ordenador (CGI) buscaba recrear imágenes humanas realistas, su evolución reciente ha sido radical. El verdadero punto de inflexión llegó a partir de 2014 con la aparición de las redes generativas adversariales (GAN), que permitieron generar imágenes, audio y vídeo con un nivel de realismo sin precedentes.

A este escenario se suma que, en los últimos años, el auge de la inteligencia artificial generativa y su enfoque multimodal, capaz de integrar texto, imagen, audio y vídeo en un mismo sistema, ha permitido que los deepfakes sean cada vez más sofisticados, baratos y fáciles de producir. Esta combinación de madurez técnica y adopción masiva explica por qué han dejado de ser una curiosidad experimental para convertirse en un fenómeno cotidiano, con efectos tangibles sobre la economía, la información y la confianza digital.

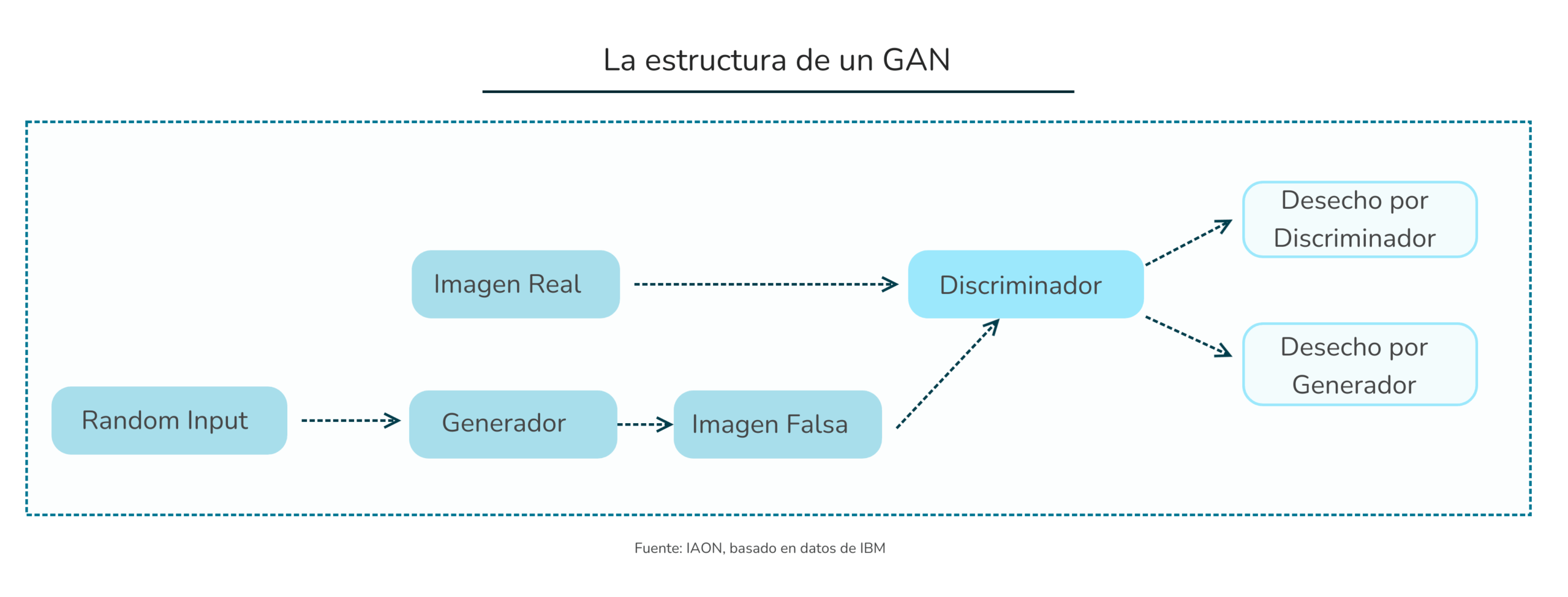

La base tecnológica de los deepfakes son redes neuronales avanzadas y, en particular, las redes generativas adversariales (GAN). Estas trabajan conjuntamente interactuando: una generando contenidos sintéticos y otra analizándolos para distinguir lo real de lo artificial. Esta cualidad les permite mejorar constantemente la calidad de los resultados, haciendo que los errores que antes permitían identificar un deepfake, como expresiones faciales incorrectas o desincronización labial, sean cada vez menos evidentes.

Su avance tecnológico les ha permitido tener un crecimiento acelerado a escala global. En los últimos años, el volumen de deepfakes se ha duplicado aproximadamente cada seis meses[2], consolidando lo que antes era una curiosidad tecnológica como un problema real.

Se calcula que en 2025 podrían haberse compartido cerca de 8 millones de deepfakes, frente a los aproximadamente 500.000 registrados en 2023. Europol advierte además que, de mantenerse esta tendencia, hasta el 90 % del contenido en línea podría ser generado de forma sintética en 2026, impulsado por su difusión veloz a través de redes sociales, aplicaciones de mensajería y plataformas de vídeo.

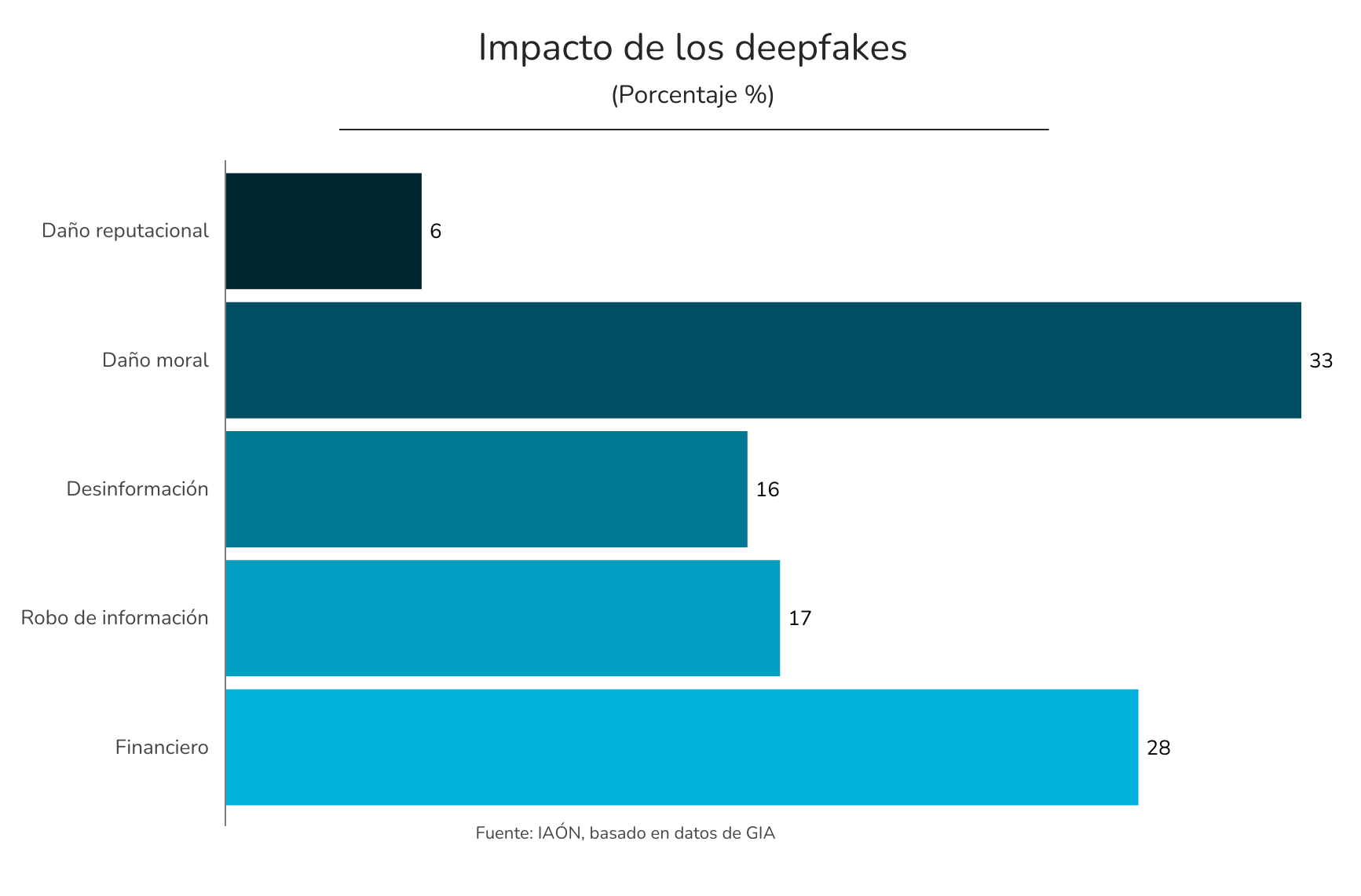

Su impacto va más allá de lo económico[3] y se manifiesta, sobre todo, en el plano personal y social. El daño moral destaca como la principal consecuencia, evidenciando el fuerte impacto psicológico que estas manipulaciones generan en las víctimas. Al mismo tiempo, el fraude financiero confirma que los deepfakes se han convertido en una herramienta eficaz para estafas y suplantaciones de identidad.

La desinformación y el robo de información refuerzan este riesgo, mientras que el daño reputacional, aunque menos frecuente, puede tener efectos profundos y duraderos, especialmente para empresas y figuras públicas.

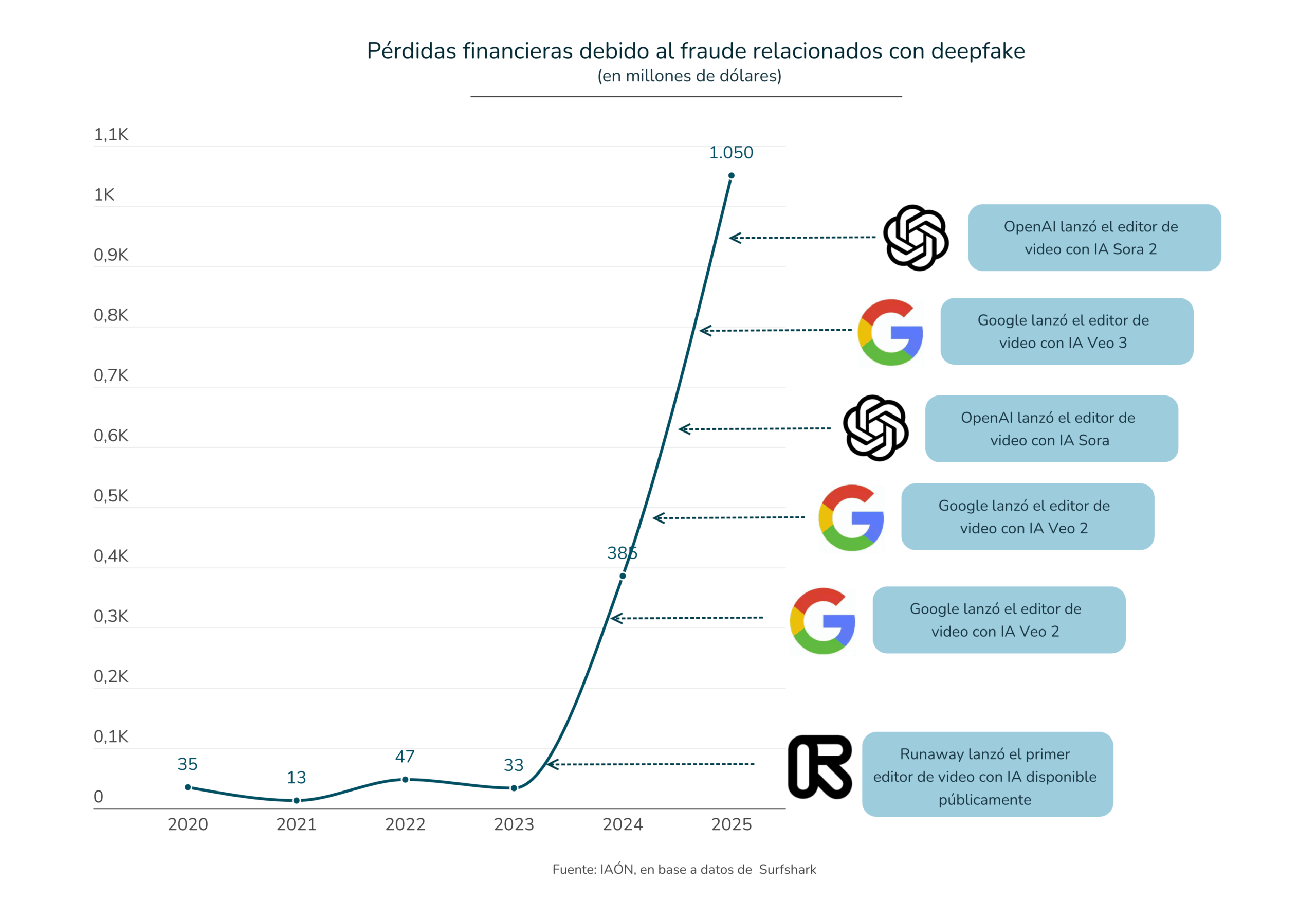

Únicamente en el ámbito financiero se estimó que para el 2025 las pérdidas financieras asociadas a esta tecnología superaron los 1.500 millones de dólares[4] frente a los 33 millones del 2023, una cifra que refleja la escala y la rapidez con la que estos riesgos se materializan.

Detrás de este impacto destacan principalmente las transferencias fraudulentas basadas en la suplantación de identidad, en particular de directivos empresariales, familiares o figuras de autoridad, seguidas por estafas románticas y falsas oportunidades de inversión, que se apoyan en la manipulación de la confianza y en la creación de situaciones de urgencia emocional para engañar a las víctimas.

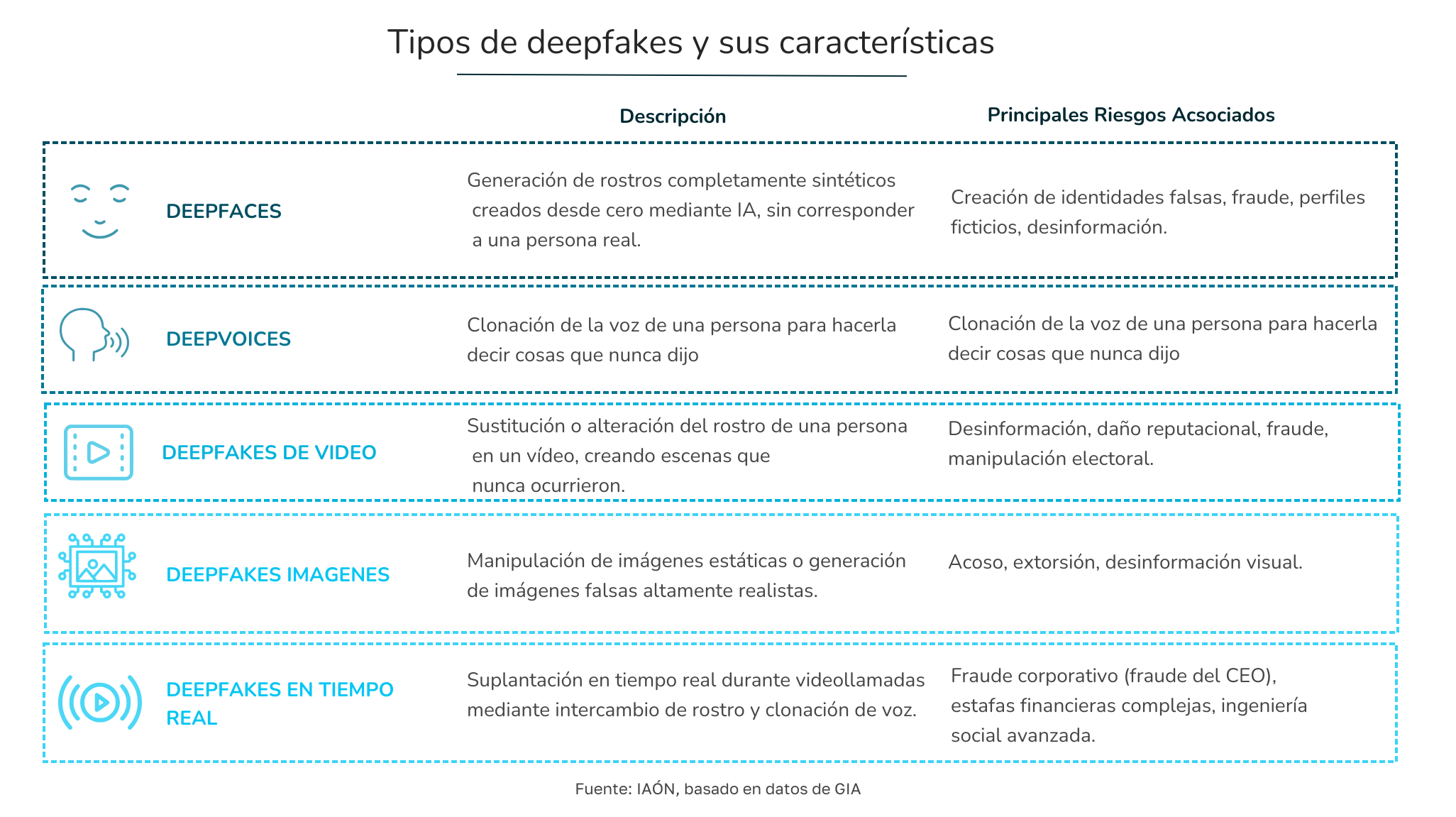

Esta no es una tecnología homogénea, sino un conjunto de técnicas que varían según el tipo de contenido manipulado y el nivel de sofisticación alcanzado. Las falsificaciones pueden afectar a imágenes, audio o vídeo, e incluso combinarse en tiempo real para crear suplantaciones prácticamente indistinguibles de una interacción auténtica.

Mientras que los primeros deepfakes se limitaban principalmente al intercambio de rostros en vídeos, la evolución de la inteligencia artificial ha permitido avanzar hacia la clonación de voces y la suplantación en directo, ampliando de forma significativa los riesgos asociados.

Esta diversidad técnica explica por qué los deepfakes se utilizan hoy en fraudes financieros, campañas de desinformación, abusos de identidad y ataques altamente dirigidos, y por qué su detección resulta cada vez más compleja

Ante un volumen creciente de contenidos sintéticos cada vez más difíciles de distinguir de la realidad, el desafío ya no es solo entender cómo funcionan los deepfakes, sino identificar con claridad dónde están generando problemas reales y qué estamos haciendo como sociedad para enfrentarlos.

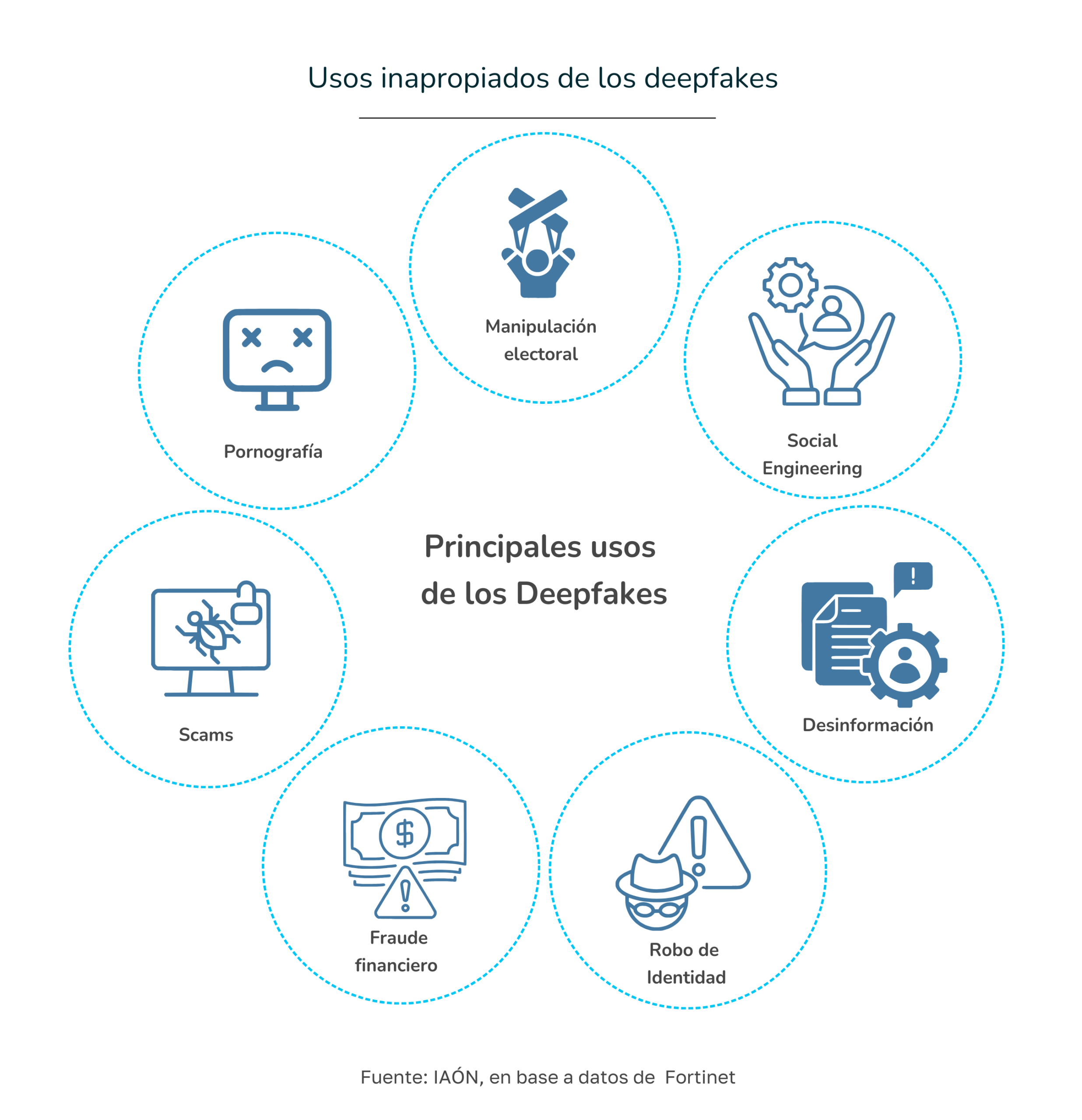

El uso malintencionado de los deepfakes se extiende de forma transversal a distintos ámbitos de la vida social. En todos ellos, los contenidos sintéticos generados mediante inteligencia artificial están erosionando la confianza, poniendo en riesgo la privacidad y tensionando el funcionamiento normal de instituciones, mercados y relaciones sociales.

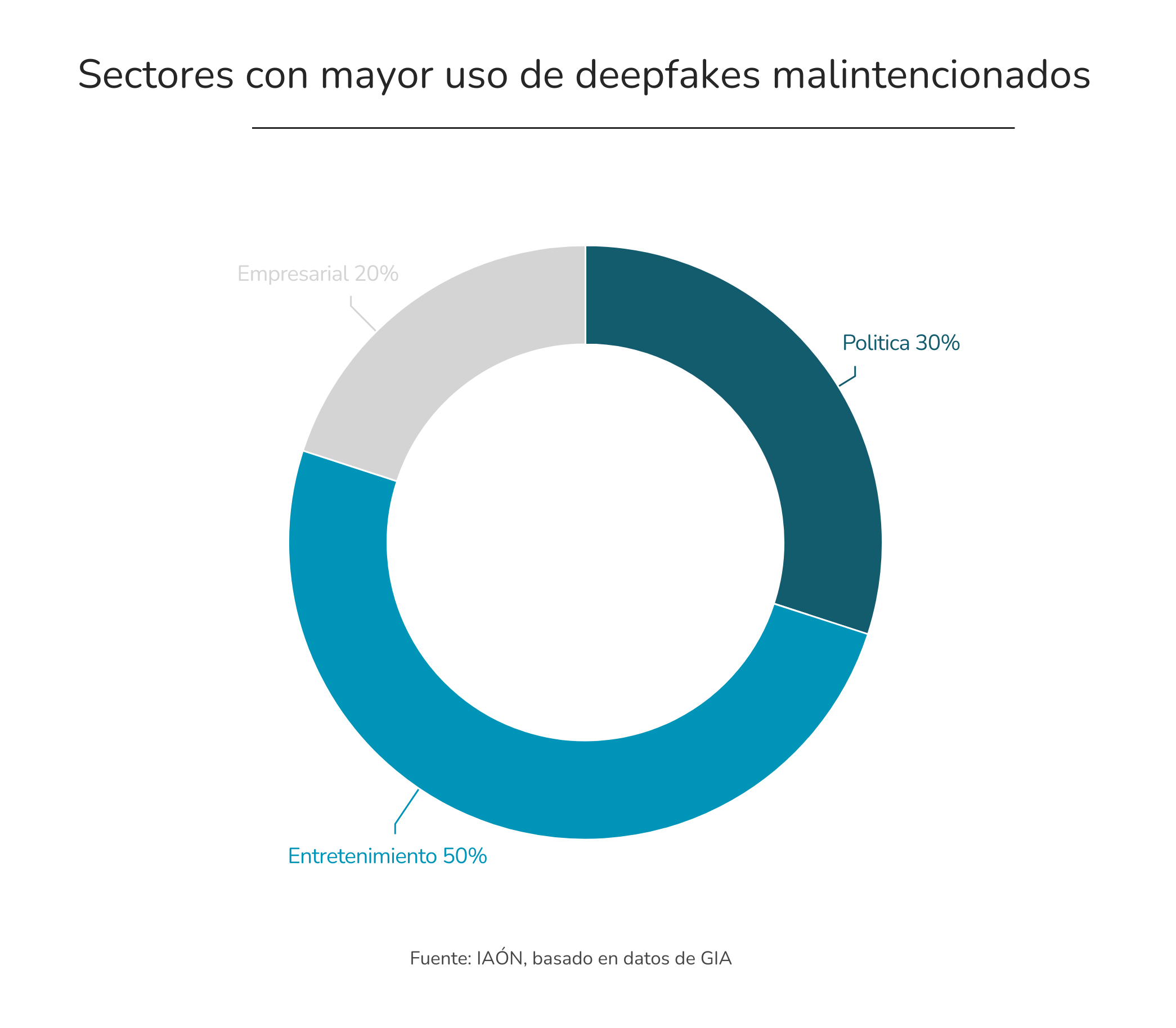

No todos los sectores se ven afectados de la misma manera ni con la misma intensidad. La proliferación de deepfakes responde tanto a incentivos económicos como políticos y sociales, y se apoya en un ecosistema digital que facilita su creación y rápida difusión. En este contexto, resulta clave identificar dónde están causando mayores problemas y por qué ciertos ámbitos concentran un mayor volumen de usos maliciosos.

Los datos muestran que el empleo de deepfakes con fines dañinos se concentra especialmente en tres grandes áreas: el entretenimiento, la política y el entorno empresarial. En estos ámbitos, los deepfakes se utilizan para desinformar, manipular percepciones, dañar reputaciones o ejecutar fraudes, aprovechando tanto la viralidad de las plataformas como la dificultad creciente para distinguir entre lo real y lo artificial.

Comprender cómo y por qué los deepfakes impactan en cada uno de estos sectores es un paso fundamental para dimensionar la magnitud del problema y anticipar los riesgos futuros.

Aunque los deepfakes se utilizan con diversos fines, el principal uso malicioso que impulsa la inversión y la innovación en este ámbito es el fraude. Solo en Estados Unidos, las pérdidas asociadas a este tipo de delitos se estimaron en 12.300 millones de dólares en 2023 y podrían alcanzar los 40.000 millones en 2027, lo que supone una tasa de crecimiento anual compuesta del 32%[5] .

Pero este impacto no se limita a un solo país: ya se observa a nivel global. En México, por ejemplo, las empresas afectadas por ataques de este tipo registran pérdidas promedio de 627.000 dólares por incidente. En Singapur, la cifra alcanza los 577.000 dólares. Alemania y los Emiratos Árabes Unidos presentan pérdidas ligeramente menores, aunque igualmente significativas, de 394.000 y 379.000 dólares, respectivamente. Estos números muestran que los deepfakes se han convertido en un riesgo financiero real y transversal.

Para el sector del comercio electrónico, que depende de la confianza entre consumidores y empresas, esta evolución del fraude representa un desafío particularmente crítico. Los intentos de fraude global crecen aproximadamente un 21% cada año, y hoy se estima que 1 de cada 20 intentos fallidos de verificación de identidad involucra deepfakes.

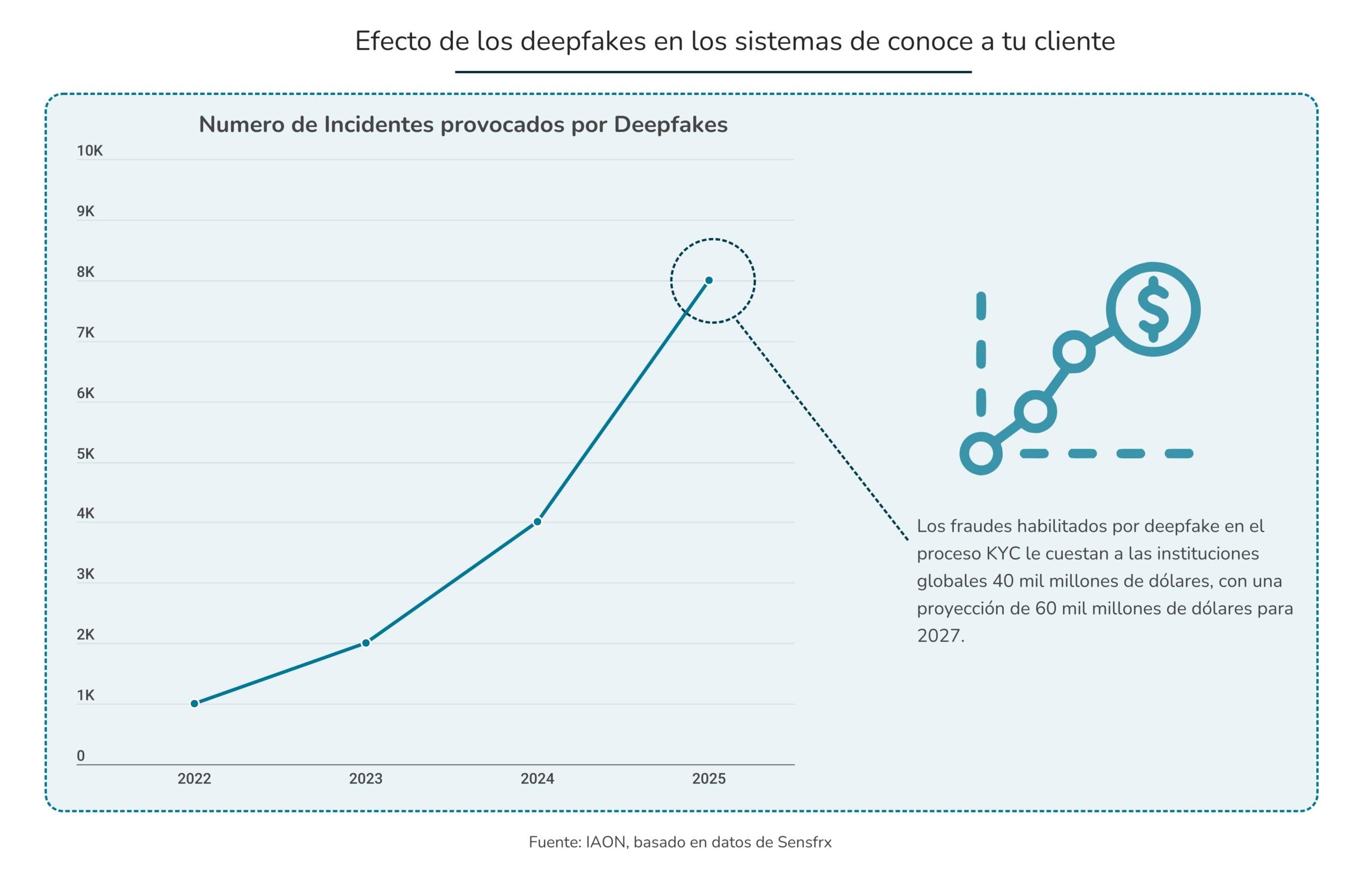

Uno de los principales objetivos de estos ataques son los procesos de incorporación digital de clientes. Los sistemas de “Know your client” (KYC), que dependen de la verificación mediante vídeo, son vulnerables a identidades sintéticas generadas con deepfakes.

Herramientas como Deepfakes Web permiten eludir sistemas de reconocimiento facial y detección básica, facilitando la creación de cuentas fraudulentas que pueden utilizarse para blanqueo de capitales o préstamos ilícitos. Es por esto que, el fraude KYC habilitado por deepfakes ya genera pérdidas globales estimadas en 40.000 millones de dólares[6], con una previsión de 60.000 millones para 2027.

Este tipo de fraude no se limita a los procesos de alta de clientes, sino que se extiende también a los sistemas de autenticación que sustentan gran parte de la economía digital. La autenticación biométrica, como el reconocimiento facial o el desbloqueo por voz, se ha generalizado como mecanismo de seguridad, pero ha demostrado ser vulnerable frente al uso de deepfakes.

Los estafadores recurren a vídeos generados por IA y a audios clonados para engañar a los sistemas de reconocimiento facial y de voz, superando controles que hasta hace poco se consideraban fiables.

Una especial preocupación genera los denominados “injection attacks”, que en 2024 se multiplicaron por nueve: en lugar de interactuar con el sensor, los atacantes introducen directamente medios sintéticos en los flujos de autenticación, eludiendo los mecanismos de detección.

En un contexto en el que solo en Estados Unidos 187,5 millones de personas realizaron compras desde el móvil en 2024, cerca del 50 % de las ventas de comercio electrónico, estas vulnerabilidades amplifican de forma significativa el riesgo de fraude y erosionan la confianza en los sistemas de verificación biométrica.

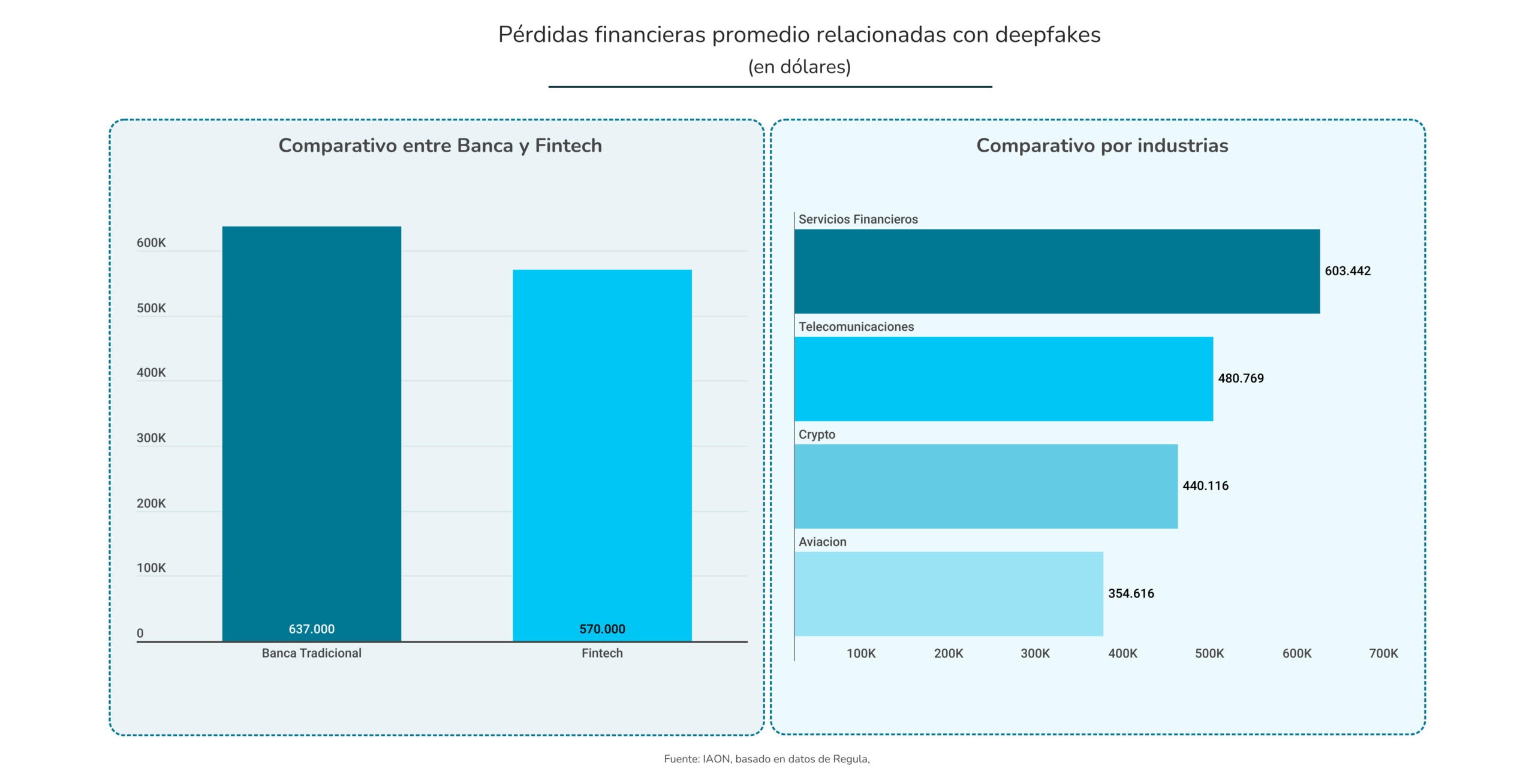

Entre todas las industrias, el sector financiero es el más afectado. Hasta 2024, el 23% de estas organizaciones reportó pérdidas superiores al millón de dólares por fraudes generados mediante inteligencia artificial, duplicando la media global de otros sectores.

Dentro de este ámbito, las fintech registran un impacto aún mayor que la banca tradicional, con pérdidas medias de 637.000 dólares frente a los 570.000 dólares de los bancos. Esta diferencia refleja la mayor exposición de las fintech a canales completamente digitales y la velocidad con que los atacantes explotan nuevas vulnerabilidades.

Los deepfakes no solo representan un problema tecnológico o económico, sino que también afectan de forma directa a la calidad de la información pública y al funcionamiento de los sistemas democráticos.

Su capacidad para simular de manera creíble a personas reales los convierte en una herramienta especialmente eficaz para la desinformación, erosionando la confianza en las instituciones, en los medios y en los propios procesos electorales.

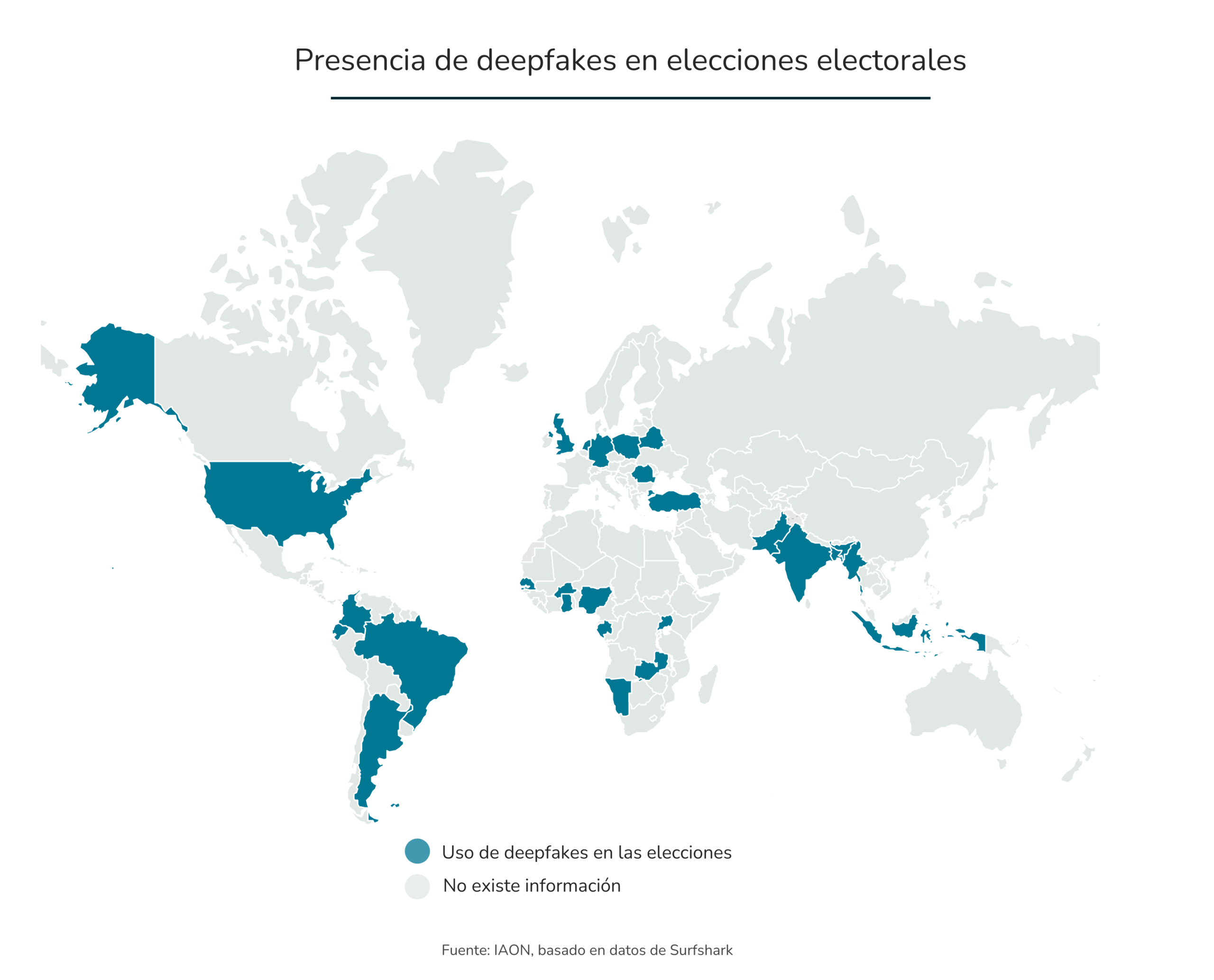

Desde 2021, al menos 38 países han registrado incidentes relacionados con deepfakes[7] durante periodos electorales, con un impacto potencial sobre unos 3.800 millones de personas.

La magnitud del fenómeno es global: Norteamérica concentra el 78 % de los casos reportados, seguida de Sudamérica (76 %), Asia (50 %), Europa (35 %), África (28 %) y Oceanía (12 %). Estos datos muestran que la manipulación mediante contenidos sintéticos ya no es un riesgo aislado, sino un desafío estructural para la democracia.

Algunos episodios recientes ilustran claramente este problema. En las primarias de New Hampshire de 2024, en Estados Unidos, miles de votantes recibieron llamadas automáticas con una voz generada por inteligencia artificial que imitaba al presidente Joe Biden y les instaba falsamente a no participar en las elecciones.

En India, durante las elecciones generales de 2024, los partidos políticos destinaron cerca de 50 millones de dólares a contenidos generados por IA. Como consecuencia, millones de personas estuvieron expuestas a deepfakes de políticos, celebri dades e incluso líderes fallecidos, en un contexto de alta polarización y con una enorme capacidad de difusión.

La gravedad del impacto se ve amplificada por los canales de propagación. Las redes sociales estuvieron presentes en el 92% de los incidentes analizados, seguidas por las aplicaciones de mensajería privada y la publicidad digital dirigida, ambas con un 32 %.

Incluso los medios tradicionales, como la radio y la televisión, participaron en casi una cuarta parte de los casos. Esta combinación de realismo técnico y difusión masiva dificulta la verificación, acelera la propagación de contenidos falsos y debilita el debate público informado.

La sociedad también se está viendo afectada por los deepfakes, que impactan de forma directa en la confianza colectiva, un efecto que se intensifica a medida que su uso se vuelve cada vez más extendido y accesible.

Esta tecnología se encuentra cada vez más presentes en múltiples espacios de la vida digital, facilitando estafas y engaños que dañan la reputación y las finanzas de empresas, generando pornografía no consensuada, posibilitando la suplantación de identidad y alimentando campañas de desinformación o manipulación electoral mediante vídeos falsos de líderes y figuras públicas.

Esta presencia generalizada está erosionando la confianza en el entorno digital, creando una duda constante sobre la autenticidad de los contenidos que consumimos. Estudios recientes muestran que las personas cada vez tienen más dificultades para distinguir entre información real y generada por IA, con tasas de detección que apenas alcanzan el 50 %.

A este se le debe sumar que, entre todos los tipos de contenido generado por IA, los deepfakes de voz son los más convincentes y difíciles de detectar. El acceso a este material es sencillo, el 53 % de las personas comparte su voz en línea o mediante mensajes grabados al menos una vez por semana, ampliando continuamente la superficie de exposición.

Con apenas tres segundos de audio, es posible generar un clon con una coincidencia de voz cercana al 85 % respecto al hablante original.

A medida que los deepfakes de voz ganan precisión, los ataques altamente dirigidos se vuelven más frecuentes, pudiendo derivar en transacciones no autorizadas, brechas de datos y sofisticados esquemas de ingeniería social.

No sorprende, por tanto, que una encuesta revele que uno de cada cuatro adultos ha sufrido, o conoce a alguien que ha sufrido, una estafa basada en clonación de voz con IA, mientras que el 70 % reconoce no sentirse capaz de distinguir con seguridad entre una voz real y una clonada.

En este contexto de mejora sostenida en la calidad y credibilidad de los deepfakes, los menores de edad se convierten en uno de los colectivos más vulnerables. Sus capacidades cognitivas y críticas aún están en desarrollo, lo que dificulta la identificación de manipulaciones cada vez más sofisticadas.

Mientras que solo el 9 % de los adultos afirma sentirse seguro de su capacidad para detectar deepfakes, un porcentaje incluso mayor (el 20 % de los niños de entre 8 y 15 años) declara tener esa confianza, lo que pone de manifiesto una preocupante brecha entre percepción y capacidad real de detección.

A esta vulnerabilidad se suma un elevado nivel de exposición. Según investigaciones de Ofcom, el 50 % de los niños del Reino Unido de entre 8 y 15 años afirma haber visto al menos un deepfake en los últimos seis meses.

Además, la creciente demanda de deepfakes sexualmente explícitos agrava de forma significativa los riesgos psicológicos, sociales y legales a los que se enfrentan los menores, reforzando la urgencia de abordar este fenómeno desde una perspectiva de protección, prevención y responsabilidad compartida.

Frente a esta realidad, surge una pregunta clave: ¿qué medidas se están implementando actualmente para mitigar estos riesgos y qué tan efectivas resultan frente a un fenómeno que evoluciona a la misma velocidad que la inteligencia artificial que lo genera?

Este interrogante abre el camino a explorar cómo gobiernos, empresas y la sociedad están intentando responder a los problemas que los deepfakes están causando en distintos ámbitos.

Frente a la expansión acelerada de los deepfakes y a los riesgos cada vez más visibles que generan en la economía, la vida social y los procesos democráticos, resulta evidente que no existe una solución única ni inmediata. La respuesta a esta amenaza emergente requiere un enfoque integral y coordinado, basado en tres pilares complementarios.

Por un lado, la educación desempeña un papel clave en la prevención, al fortalecer el pensamiento crítico y la capacidad de las personas para identificar contenidos manipulados. Por otro, la tecnología es fundamental para detectar y mitigar la propagación de deepfakes mediante herramientas de verificación, trazabilidad y análisis automatizado.

Finalmente, la regulación resulta imprescindible para sancionar los usos ilícitos y establecer límites claros, generando incentivos para un desarrollo responsable de la inteligencia artificial. Solo la combinación equilibrada de estos tres ejes permite abordar de forma eficaz una amenaza que evoluciona al mismo ritmo que la tecnología que la impulsa.

Desde el punto de vista tecnológico, la respuesta frente a este riesgo se articula, en términos generales, en torno a dos grandes enfoques complementarios: la prevención y la detección. Ambos buscan reducir el daño potencial de los contenidos sintéticos, aunque lo hacen desde lógicas distintas y con retos específicos.

En el ámbito de la prevención, destacan las técnicas orientadas a reforzar la transparencia y la trazabilidad del contenido, como el uso de marcas de agua digitales[8] o el apoyo en infraestructuras basadas en blockchain.

Fuente: The verge

Las marcas de agua consisten en incrustar señales en los contenidos generados por IA para indicar su origen sintético y facilitar la identificación de quién los creó y con qué herramientas.

Aunque tienen un gran potencial, estas soluciones presentan limitaciones relevantes. Las marcas de agua pueden eliminarse o degradarse, y su eficacia depende de una adopción amplia y coherente por parte de toda la industria. Si solo algunos actores las aplican, el resultado puede ser confuso para los usuarios, que podrían interpretar erróneamente contenidos no etiquetados como auténticos.

Para mitigar este riesgo, empresas como Microsoft[9] están desarrollando marcas de agua invisibles al ojo humano, más resistentes a la manipulación, aunque el desafío de la estandarización sigue siendo central.

Más allá de las medidas preventivas, se están desarrollando soluciones tecnológicas específicamente orientadas a la detección de deepfakes. En una primera etapa, estas herramientas se apoyaban principalmente en la identificación de señales visuales evidentes, como bordes difuminados o inconsistencias en las imágenes.

Sin embargo, la evolución de las técnicas de machine learning han aprovechado las grandes cantidades de datos disponibles en línea para entrenar sus modelos de detección.

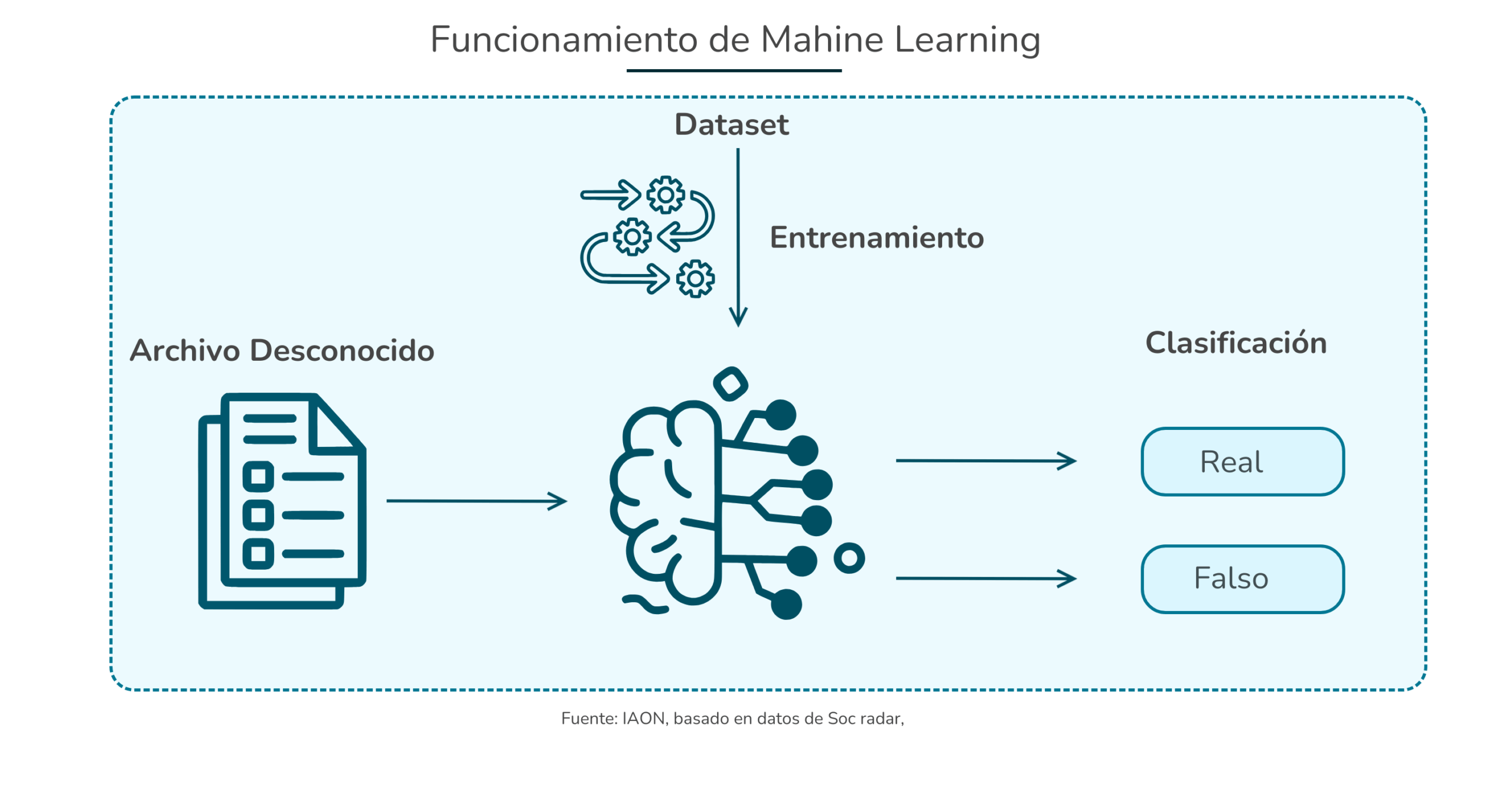

El machine learning[10] es una rama de la inteligencia artificial que permite a los sistemas aprender a partir de datos y mejorar su rendimiento sin necesidad de ser programados explícitamente para cada caso.

En lugar de seguir reglas fijas, estos modelos analizan grandes volúmenes de información, identifican patrones complejos y ajustan su comportamiento conforme se enfrentan a nuevos ejemplos.

Esta capacidad de adaptación resulta especialmente valiosa en ámbitos como la ciberseguridad, donde las amenazas evolucionan con rapidez y requieren respuestas dinámicas y escalables.

Aplicado a la detección de deepfakes, el machine learning permite entrenar sistemas capaces de identificar señales sutiles que diferencian un contenido real de uno generado artificialmente.

Los detectores analizan inconsistencias faciales, como movimientos oculares poco naturales, desajustes en la sincronización labial o anomalías en la textura de la piel, patrones biométricos como variaciones en el tono de voz o la cadencia del habla, así como metadatos y huellas digitales que revelan el origen y la posible manipulación de los archivos.

Además, incorporan análisis conductual para detectar diferencias entre las expresiones humanas auténticas y las generadas por IA. Estas herramientas ya se emplean en ámbitos como la ciberseguridad, el periodismo, la verificación de identidad y la aplicación de la ley, convirtiéndose en un pilar clave para combatir el fraude, la desinformación y la manipulación digital en un entorno cada vez más dominado por contenidos sintéticos.

No obstante, estos sistemas presentan ciertas limitaciones. Entre los que destacan están que los avances en detección proporcionan información valiosa sobre qué elementos hacen identificable a un deepfake, lo que puede incentivar el desarrollo de contenidos diseñados específicamente para eludir los mecanismos de control.

A ello se suma que los proveedores de IA no están obligados a hacer públicos los conjuntos completos de datos utilizados para entrenar sus modelos, lo que limita la supervisión independiente sobre su idoneidad o legalidad.

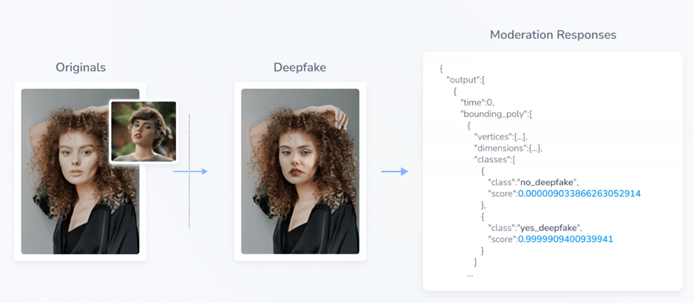

Algunas empresas tecnológicas ya están desarrollando soluciones concretas para hacer frente a este desafío. Un ejemplo destacado es Hive AI, que ha creado una API de detección de deepfakes diseñada para identificar contenido generado por inteligencia artificial en imágenes y vídeos.

Esta herramienta se utiliza especialmente en tareas de moderación de contenidos, ayudando a plataformas digitales a detectar y eliminar medios manipulados, incluidos deepfakes no consensuados y campañas de desinformación generadas por IA.

El funcionamiento de la tecnología de Hive se basa en un enfoque escalonado. En primer lugar, el sistema detecta los rostros presentes en una imagen o en cada fotograma de un vídeo. A continuación, aplica un modelo de clasificación que etiqueta cada rostro como deepfake o no deepfake, asignando un nivel de confianza a cada resultado.

Estos modelos han sido entrenados con conjuntos de datos amplios y diversos, que combinan vídeos reales y sintéticos de distintos contextos, lo que les permite identificar manipulaciones incluso cuando el contenido resulta altamente realista para el ojo humano.

Fuente: Hive

La relevancia de estas soluciones ha trascendido el ámbito comercial. Consciente de las implicaciones que los deepfakes tienen para la seguridad nacional, el Departamento de Defensa de Estados Unidos ha invertido 2,4 millones de dólares en las herramientas de detección de Hive AI, seleccionando a la empresa entre más de treinta candidatos para apoyar a la Unidad de Innovación en Defensa en la lucha contra la desinformación y las amenazas derivadas de medios sintéticos.

No obstante, los propios expertos subrayan que, pese a estos avances, ninguna herramienta es completamente infalible y que los actores maliciosos continúan buscando formas de eludir los sistemas de detección.

En este contexto, si bien la tecnología constituye un componente imprescindible de la respuesta frente a los deepfakes, sus límites actuales refuerzan una conclusión clave: sin una coordinación efectiva entre la industria, la adopción de principios de diseño responsables y un sólido respaldo regulatorio, las soluciones técnicas por sí solas resultarán insuficientes para contener el impacto de esta nueva ola de desinformación generada por IA.

La amenaza que supone el uso indebido de los deepfakes también ha despertado la preocupación de gobiernos de todo el mundo. Sin embargo, como ocurre con frecuencia en entornos de rápida innovación tecnológica, el desarrollo normativo avanza a un ritmo más lento que la propia tecnología.

Aun así, comienzan a surgir marcos legales y medidas concretas orientadas a mitigar los riesgos asociados al contenido sintético.

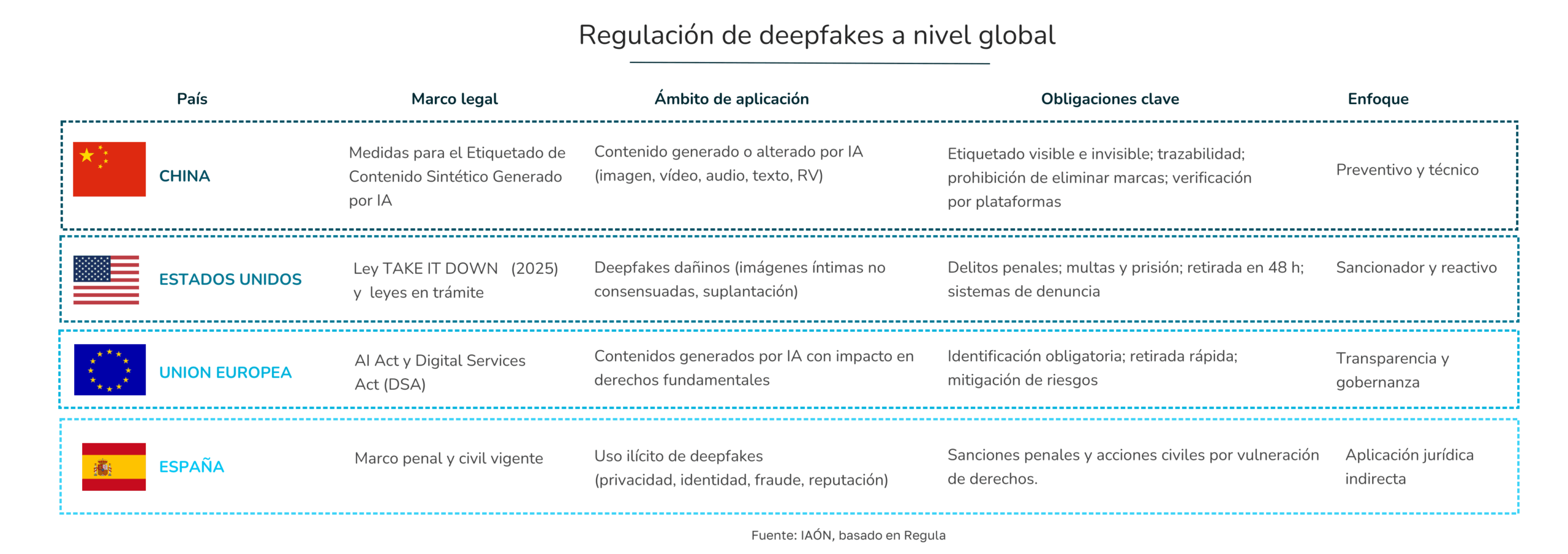

La regulación de los deepfakes muestra enfoques muy distintos a nivel global. Mientras China apuesta por un modelo altamente preventivo y técnico, basado en el etiquetado obligatorio y la trazabilidad del contenido sintético, Estados Unidos ha optado por un enfoque más reactivo y sancionador, centrado en la protección de las víctimas y la retirada rápida de contenidos dañinos.

En la Unión Europea, la respuesta se articula desde la gobernanza y la transparencia, integrando los deepfakes dentro de un marco más amplio de regulación de la inteligencia artificial y de las plataformas digitales.

La Ley de Inteligencia Artificial[11] establece un régimen sancionador escalonado que busca disuadir los usos más perjudiciales de la IA y garantizar el cumplimiento efectivo de sus obligaciones. Las sanciones varían en función de la gravedad de la infracción y pueden combinar consecuencias económicas con medidas administrativas que afectan directamente a la operativa de las organizaciones. Las infracciones pueden tener multas que van desde el 1% hasta el 7% de la facturación.

España, por su parte, está abordando el fenómeno de los deepfakes a través de la aplicación del marco penal y civil ya existente. En este contexto, en noviembre de 2025, la Agencia Española de Protección de Datos (AEPD) impuso la primera sanción en Europa relacionada con la creación de un deepfake.

La autoridad consideró sancionó al responsable con una multa de 2.000 euros. Este caso marcó un precedente relevante sobre cómo las autoridades pueden actuar frente a usos abusivos de la IA incluso en ausencia de una regulación específica sobre deepfakes.

La educación y la concienciación social constituyen uno de los pilares fundamentales para mitigar los riesgos asociados a los deepfakes. Comprender cómo funciona la inteligencia artificial generativa, cuáles son sus límites y de qué forma puede utilizarse de manera indebida permite a las personas desarrollar pensamiento crítico y reducir su vulnerabilidad frente a la manipulación, el fraude y la desinformación.

En este sentido, cada vez más expertos coinciden en que prohibir la IA no es la solución: la respuesta pasa por fomentar la educación tecnológica y ética, así como promover una mirada crítica ante los contenidos digitales desde edades tempranas.

Este enfoque resulta especialmente relevante en el caso de niños y adolescentes, que son a la vez grandes consumidores de contenido digital y un colectivo particularmente expuesto. Educar en ética de la IA no solo ayuda a que no caigan en prácticas maliciosas, como la creación o difusión de deepfakes, sino que también refuerza valores clave como el consentimiento, el respeto a la privacidad y la responsabilidad digital.

Crear espacios de diálogo abiertos entre familias, escuelas y menores es esencial para que puedan expresar dudas, identificar riesgos y pedir ayuda cuando se enfrenten a situaciones de acoso o manipulación.

En el hogar, una forma efectiva de educación es explorar el fenómeno de manera conjunta[12]. Ver ejemplos de deepfakes y analizarlos en familia o en el aula permite explicar por qué existen, para qué pueden utilizarse y cuáles son sus consecuencias.

Estas conversaciones facilitan introducir conceptos como el consentimiento, por qué no se debe usar la imagen o la voz de alguien sin permiso, y refuerzan la idea de que el uso de esta tecnología con fines de acoso o humillación debe ser comunicado a adultos de confianza o a la propia escuela.

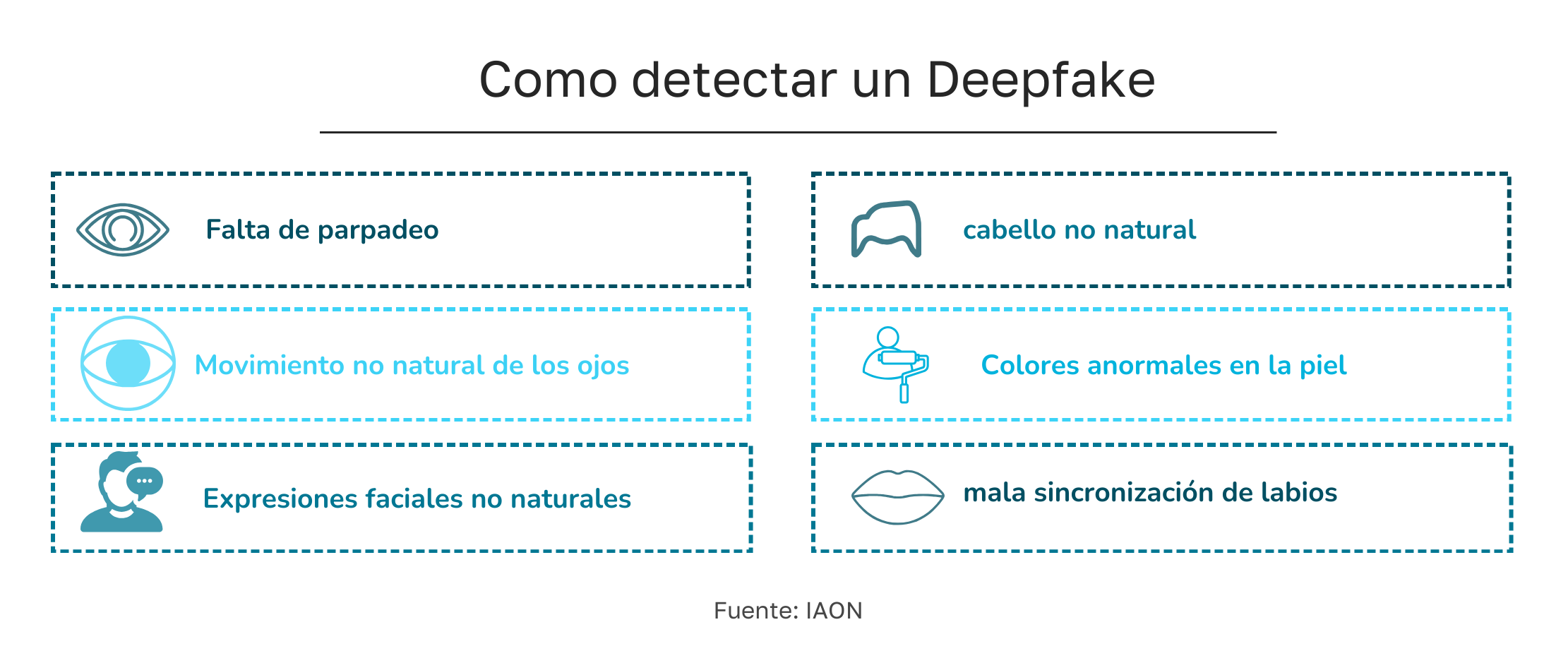

Otro aspecto clave es aprender a diferenciar contenidos reales de manipulados. Aunque esta tarea es cada vez más compleja, observar ciertos detalles puede ayudar: parpadeos poco naturales, desajustes entre el audio y el movimiento de los labios, expresiones faciales rígidas, fallos en la iluminación o sombras incoherentes.

También es importante analizar el contenido del mensaje: cuando un vídeo contiene afirmaciones escandalosas o busca provocar una reacción emocional intensa, aumenta la probabilidad de que se trate de un deepfake. Existen además herramientas de apoyo, como soluciones de análisis de vídeo desarrolladas por grandes empresas tecnológicas, que pueden orientar sobre la probabilidad de manipulación.

La educación también pasa por reflexionar sobre lo que se comparte en internet. Fotografías, vídeos o audios publicados en redes sociales pueden ser utilizados, sin saberlo, como materia prima para crear deepfakes dañinos.

Hablar con los menores sobre privacidad, configurar adecuadamente las opciones de seguridad y priorizar espacios de intercambio más cerrados ayuda a reducir la exposición. Proponer alternativas y explicar riesgos suele ser más eficaz que imponer prohibiciones.

Finalmente, explorar juntos las herramientas puede convertirse en una oportunidad educativa. Probar aplicaciones que permiten crear deepfakes con fines lúdicos, siempre desde una perspectiva crítica y responsable, ayuda a comprender tanto el potencial como los riesgos de la tecnología.

De este modo, los deepfakes dejan de ser un fenómeno abstracto y se convierten en una herramienta para enseñar sobre engaños digitales, noticias falsas y uso ético de la inteligencia artificial.

Aunque no existe un método infalible, algunos indicios frecuentes pueden alertar sobre contenido manipulado: movimientos oculares poco naturales, ausencia de parpadeo, expresiones faciales rígidas, desajustes entre rostro y cuerpo, colores de piel anómalos, iluminación incoherente o sincronización incorrecta de los labios.

También pueden observarse movimientos bruscos, perspectivas extrañas o distorsiones cuando la persona gira la cabeza o se desplaza.

En conjunto, la educación no elimina el riesgo de los deepfakes, pero sí reduce de forma significativa su impacto. Dotar a niños, jóvenes y adultos de herramientas críticas, éticas y prácticas es una de las estrategias más eficaces para construir una sociedad más resiliente frente a la manipulación digital.

Los deepfakes representan un fenómeno complejo que ha evolucionado de una curiosidad tecnológica a un riesgo sistémico con impactos tangibles en la economía, la política, la sociedad y la confianza digital.

Su rápido avance, impulsado por la inteligencia artificial generativa y el uso de modelos multimodales, ha permitido crear contenidos audiovisuales cada vez más realistas y difíciles de diferenciar de la realidad.

Esta evolución ha ampliado significativamente su presencia, afectando desde la reputación y las finanzas de empresas hasta la integridad de procesos democráticos y la protección de los colectivos más vulnerables, como los menores de edad.

El alcance global de los deepfakes se refleja en pérdidas económicas multimillonarias, fraudes financieros en distintos países, manipulación electoral y una erosión generalizada de la confianza en la información digital.

A medida que los contenidos sintéticos se multiplican y su detección se vuelve más compleja, surge la necesidad de respuestas coordinadas y multidimensionales que vayan más allá de la tecnología.

Frente a esta realidad, la sociedad, las empresas y los gobiernos han comenzado a desplegar estrategias basadas en tecnología, legislación y educación. Las soluciones tecnológicas incluyen herramientas de detección de deepfakes y marcas de agua digitales; los marcos legales buscan regular la creación y difusión de contenidos manipulados, protegiendo derechos fundamentales y responsabilizando a los infractores; y la educación y alfabetización digital permiten a los usuarios desarrollar pensamiento crítico y habilidades para identificar contenido sintético.

El desafío es claro: los deepfakes no pueden abordarse de manera aislada ni con medidas fragmentadas. Su mitigación requiere un enfoque integral, coordinado y proactivo que combine innovación tecnológica, regulación efectiva y conciencia social, con el objetivo de preservar la confianza, la seguridad y la integridad de nuestro entorno digital frente a una amenaza que sigue creciendo y evolucionando.

[1] UNIVERSIDAD ISABEL I. Deepfake: el desafío de la verdad en la era digital. 2024. [Consultado el 02–01–2026]. Disponible en: https://www.ui1.es/blog-ui1/deepfake-el-desafio-de-la-verdad-en-la-era-digital

[2] EUROPEAN PARLIAMENTARY RESEARCH SERVICE (EPRS). Deepfake technology creating media content. 2025. [Consultado el 02–01–2026]. Disponible en: https://www.europarl.europa.eu/RegData/etudes/BRIE/2025/775855/EPRS_BRI(2025)775855_EN.pdf

[3] ISMS FORUM. Deepfake. 2024. [Consultado el 13–01–2026]. Disponible en: https://www.ismsforum.es/ficheros/descargas/deepfake-final1742458135.pdf

[4] SURFSHARK. AI deepfake losses. 2024. [Consultado el 02–01–2026]. Disponible en: https://surfshark.com/research/chart/ai-deepfake-losses

[5] DEEPSTRIKE. Deepfake statistics 2025. 2025. [Consultado el 02–01–2026]. Disponible en: https://deepstrike.io/blog/deepfake-statistics-2025

[6] SENSFRX. E-commerce fake reviews & deepfake fraud. 2024. [Consultado el 02–01–2026]. Disponible en: https://blog.sensfrx.ai/ecommerce-fake-reviews-deepfake-fraud/

[7] SURFSHARK. Election-related deepfakes. 2024. [Consultado el 23–12–2025]. Disponible en: https://surfshark.com/research/chart/election-related-deepfakes

[8] THE VERGE. Watermarking generative AI deepfakes could help with copyright and misinformation. Febrero 2024. [Consultado el 02–01–2026]. Disponible en: https://www.theverge.com/2024/2/13/24067991/watermark-generative-ai-deepfake-copyright

[9] THE VERGE. Google DeepMind’s SynthID is an AI-generated image detector that works even after edits. Agosto 2023. [Consultado el 02–01–2026]. Disponible en: https://www.theverge.com/2023/8/29/23849107/synthid-google-deepmind-ai-image-detector

[10] SOCRADAR. How machine learning is revolutionizing cybersecurity. 2025. [Consultado el 23–12–2025]. Disponible en: https://socradar.io/blog/how-machine-learning-is-revolutionizing-cybersecurity/

[11] PROTECCIÓN DATOS LOPD. Sanciones y multas en la Ley de Inteligencia Artificial. 2025. [Consultado el 23–12–2025]. Disponible en: https://protecciondatos-lopd.com/empresas/inteligencia-artificial/ley/sanciones-multas/

[12] ESET. Qué son los deepfakes y cómo hablar de esto con los niños. 2024. [Consultado el 13–01–2026]. Disponible en: https://www.eset.com/py/acerca-de-eset/sala-de-prensa/comunicados-de-prensa/articulos-de-prensa/que-son-los-deepfakes-y-como-hablar-de-esto-con-los-ninos/