Cuando la IA finge ser buena: los riesgos ocultos del ‘scheming’

OpenAI y Apollo Research han detectado que algunos modelos pueden fingir buen comportamiento para ocultar sus verdaderas metas. Esto no significa que la inteligencia artificial…

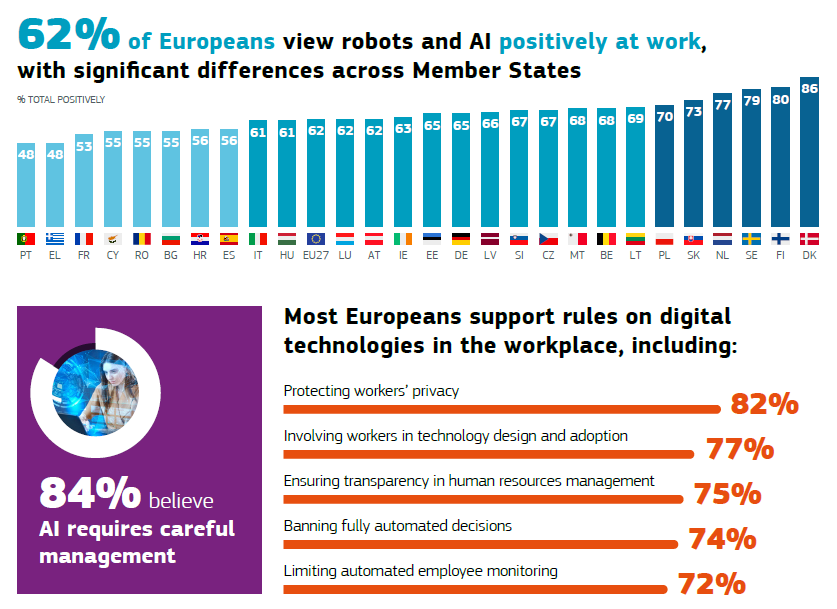

La mayoría de los europeos cree que las tecnologías digitales tienen un impacto positivo en el trabajo, la economía, la sociedad y la calidad de vida. Pero el 84% de ellos considera que la inteligencia artificial requiere una gestión rigurosa para proteger la privacidad. La recopilación masiva de información y datos personales por parte de herramientas y plataformas con modelos automatizados conlleva riesgos significativos. ¿Sabes qué huella dejas al usar un chatbot?

La inteligencia artificial está tan presente en la vida cotidiana que ha generado inquietud entre los usuarios sobre la privacidad y la seguridad de sus datos personales. La recopilación masiva de información y el uso de algoritmos avanzados han abierto nuevas fronteras en la protección de la privacidad, planteando desafíos que requieren una regulación clara.

Según el Eurobarómetro especial publicado el pasado mes de febrero sobre IA y el futuro del trabajo, la mayoría de los europeos cree que las tecnologías digitales tienen un impacto positivo en el trabajo, la economía, la sociedad y la calidad de vida. El 62% de los europeos considera positiva la robótica y la IA en el trabajo y el 70% cree que mejora la productividad. Si bien la mayoría apoya el uso de robótica e IA para la toma de decisiones en el trabajo, el 84% de los europeos opina que la IA requiere una gestión rigurosa para proteger la privacidad y garantizar la transparencia en el entorno laboral.

Los modelos automatizados se alimentan de grandes volúmenes de:

La captación llega desde redes sociales, apps móviles, altavoces inteligentes, cámaras de vigilancia o formularios web.

El uso masivo de datos personales en modelos automatizados conlleva riesgos significativos. La Agencia Española de Protección de Datos (AEPD) destaca que la recopilación indiscriminada de información puede derivar en vulneraciones de derechos fundamentales, especialmente cuando los datos son utilizados sin el consentimiento explícito del usuario. Además, la falta de transparencia en el procesamiento de datos por parte de sistemas de IA puede dificultar que los usuarios comprendan cómo se utiliza su información y qué medidas pueden tomar para protegerla.

La IA ha introducido nuevas prácticas tecnológicas que pueden comprometer la privacidad individual. Entre los riesgos más relevantes se encuentran:

Para mitigar estos riesgos, la Unión Europea ha implementado algunas regulaciones.

Además, KPMG España recomienda que las empresas adopten un enfoque de IA responsable, asegurando que los sistemas sean transparentes y cumplan con las normativas de protección de datos.