IA Verde: Claves para una revolución sostenible

El avance acelerado de la inteligencia artificial está transformando profundamente la sociedad, la economía y el medio ambiente. Su integración en múltiples sectores ofrece enormes…

La inteligencia artificial explicable se ha consolidado como un elemento estratégico para el desarrollo responsable y eficiente de soluciones basadas en IA.

En la última década, la inteligencia artificial ha experimentado un crecimiento acelerado, convirtiéndose en una tecnología clave en sectores tan diversos como la medicina, las finanzas, la educación o la industria. Su capacidad para procesar grandes volúmenes de datos, identificar patrones complejos y automatizar decisiones ha transformado la manera en que operan empresas, instituciones y servicios públicos.

Sin embargo, a medida que estos sistemas ganan protagonismo y toman decisiones que afectan directamente a las personas, surge una necesidad cada vez más urgente: entender cómo funcionan, cómo toman decisiones y por qué lo hacen de una determinada manera. Esto ha impulsado la creación de un nuevo campo: la inteligencia artificial explicable, o XAI.

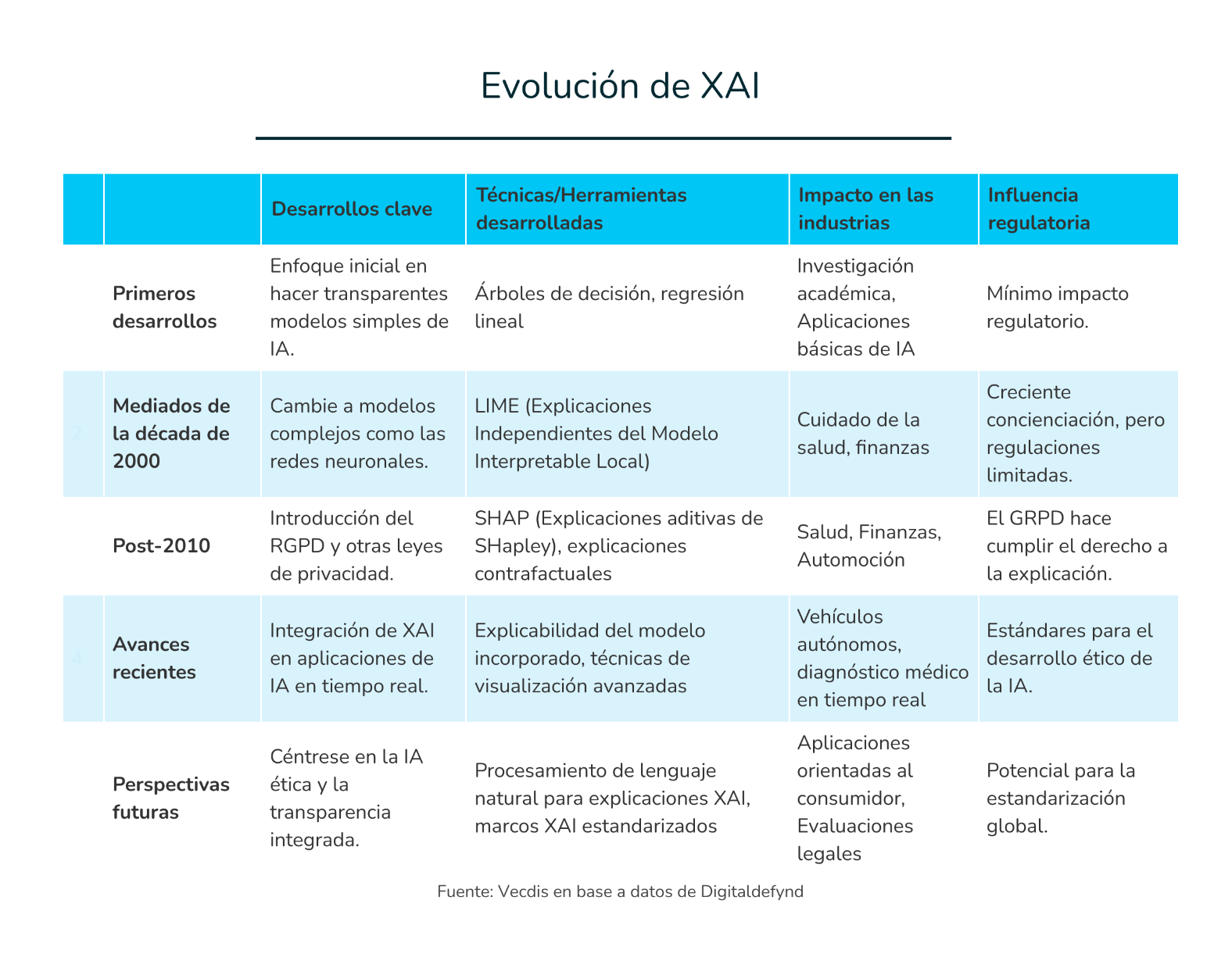

La evolución de la inteligencia artificial explicable puede entenderse en varias etapas. En sus inicios, cuando los sistemas de IA eran reglas explícitas y modelos simples como regresiones o árboles de decisión, la interpretación era directa y comprensible. Sin embargo, con la irrupción del aprendizaje profundo y los modelos de tipo «caja negra», se hizo evidente la necesidad de herramientas que permitieran entender decisiones cada vez más opacas.

Esto dio paso a una segunda etapa centrada en la creación de técnicas que pudieran aproximar o traducir las decisiones de modelos complejos. Ejemplos clave de esta fase son las técnicas LIME y SHAP, que permiten identificar cómo influyen las variables en una predicción concreta, sin necesidad de modificar el modelo original. Paralelamente, surgieron preocupaciones éticas, como los sesgos y la discriminación algorítmica, que reforzaron la necesidad de explicabilidad.

El futuro de la inteligencia artificial explicable se orienta hacia sistemas autónomos que sean no solo potentes, sino también transparentes y responsables. Entre las tendencias actuales destaca la integración de la explicabilidad en aplicaciones críticas en tiempo real, como vehículos autónomos o diagnósticos médicos. También se están desarrollando modelos con explicabilidad incorporada desde su diseño, así como interfaces capaces de ofrecer explicaciones en lenguaje natural, accesibles incluso para usuarios sin formación técnica.

Además, la dimensión ética está cobrando un papel central, con marcos que permiten evaluar la justicia y los posibles sesgos de los modelos. A esto se suma la necesidad de estandarización para garantizar coherencia en las interpretaciones, y la creciente democratización de la XAI mediante herramientas abiertas que permiten su adopción más allá de grandes empresas.[1] Todo ello apunta a una IA más comprensible y confiable, cuyo desarrollo futuro dependerá de la integración efectiva de estos avances.

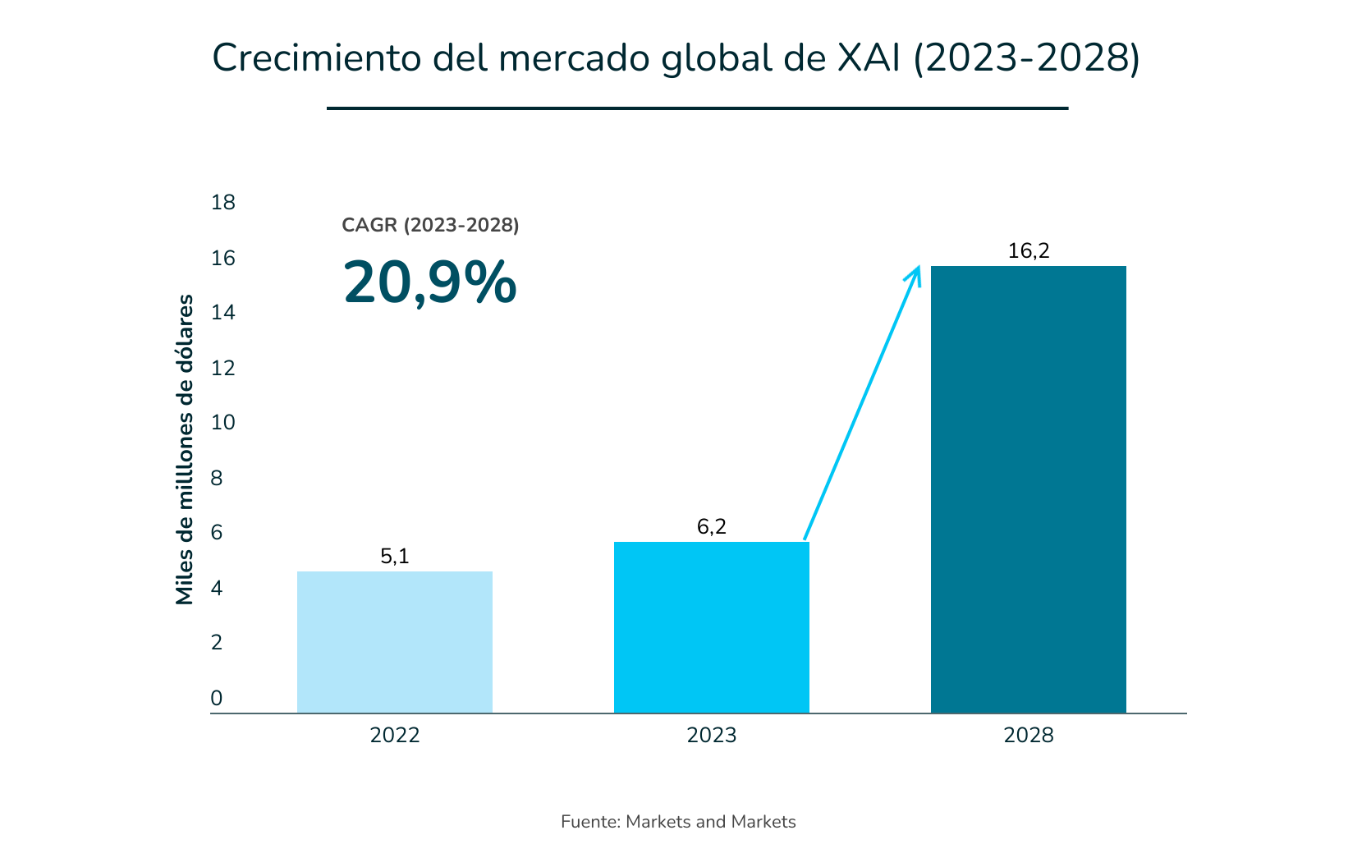

Las perspectivas de crecimiento de la inteligencia artificial explicable reflejan su creciente relevancia a nivel global. Se estima que el mercado de la XAI registrará una tasa de crecimiento anual compuesta (CAGR) del 20,9%, lo que lo llevaría a alcanzar un valor de 16.200 millones de dólares en 2028.[2]

Estados Unidos se posiciona como uno de los principales impulsores de la industria de la XAI, gracias a sus sólidos centros de investigación e innovación en IA. Grandes empresas tecnológicas y un ecosistema dinámico de startups respaldan la expansión del mercado, mientras que los estrictos requisitos regulatorios aumentan la demanda de soluciones transparentes. A esto se suma una importante financiación gubernamental y fuertes inversiones privadas que aceleran aún más el crecimiento del sector.

En Europa, la industria de la XAI experimenta un crecimiento sostenido, impulsado por marcos normativos como el Reglamento General de Protección de Datos (GDPR). Gobiernos y organizaciones priorizan el despliegue ético de la IA, con sectores como la salud y la automoción liderando su adopción. Además, las iniciativas de investigación colaborativa fortalecen el desarrollo tecnológico en la región.

Asia está emergiendo rápidamente como un actor clave en el campo de la XAI. Países como China, Japón e India están realizando importantes inversiones en tecnologías de inteligencia artificial. La creciente adopción en sectores como la salud y la manufactura, junto con una mayor concienciación y apoyo por parte de los gobiernos, están impulsando de forma significativa el crecimiento del mercado.

Este crecimiento continuado de la XAI es impulsado por su capacidad para responder a inquietudes cada vez más frecuentes en el uso industrial de la IA:

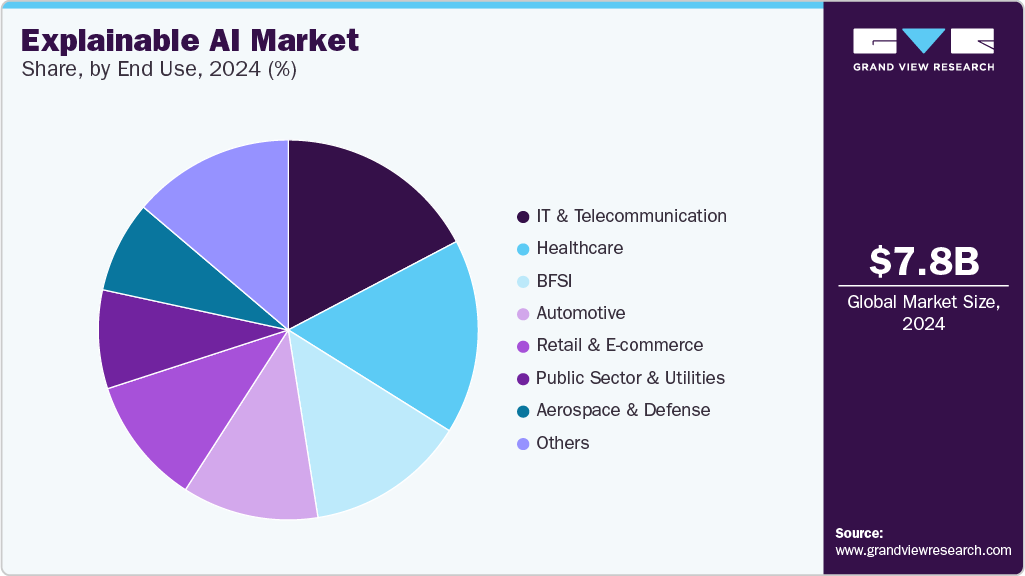

La inteligencia artificial explicable se destaca por su versatilidad, ya que puede integrarse en diversos contextos donde se requiere comprensión y transparencia. El sector de las tecnologías de la información y las telecomunicaciones lideró en 2024 con la mayor cuota de ingresos del total del valor del mercado (7.800 millones de dólares).[3] La implementación del 5G y del Internet de las Cosas (IoT) está permitiendo a organizaciones y usuarios recopilar datos del mundo real en tiempo real, lo que alimenta sistemas de inteligencia artificial cada vez más avanzados y funcionales.

Por otro lado, el segundo sector con más cuota fue el sector sanitario. A medida que la IA se emplea cada vez más en el diagnóstico, el diseño de tratamientos y la monitorización de pacientes, se vuelve imprescindible garantizar la transparencia y la confianza en sus decisiones. La XAI permite a los profesionales de la salud comprender el razonamiento detrás de las recomendaciones generadas por los sistemas inteligentes, lo que facilita su aceptación clínica y cumplimiento normativo. Esta transparencia favorece una atención médica más precisa, personalizada y centrada en el paciente.

Fuente: Grand View Research

En ese sentido, la XAI resulta clave para que diferentes sectores puedan generar confianza en el uso de la IA, al facilitar la evaluación de aspectos como la precisión del modelo, su imparcialidad, transparencia y el grado de comprensión de sus resultados en contextos de toma de decisiones.

La regulación en torno a la inteligencia artificial avanza con rapidez, impulsada por la necesidad de garantizar transparencia, responsabilidad y equidad en decisiones automatizadas que afectan a personas. Poco a poco, los marcos normativos convergen en una idea común: la IA debe ser explicable, supervisada y comprensible. Europa marca el rumbo con el AI Act, mientras que Estados Unidos y otras regiones desarrollan enfoques sectoriales o guías voluntarias. En este contexto, la inteligencia artificial explicable deja de ser solo una herramienta técnica para convertirse en un requisito normativo en sectores de alto impacto como la salud, las finanzas, la contratación, la justicia o la educación.

Estados Unidos ha adoptado diversas medidas regulatorias para fomentar el desarrollo de una inteligencia artificial más transparente y explicable. Una de las principales iniciativas es el Blueprint for an AI Bill of Rights publicado por la Casa Blanca en 2022. Este documento establece cinco principios fundamentales para proteger a los ciudadanos frente al uso de sistemas de IA: sistemas seguros y efectivos, protección contra la discriminación algorítmica, privacidad de los datos, notificación y explicación, y la posibilidad de intervención y corrección humana en caso de fallos. En particular, el principio de explicabilidad exige que los sistemas de IA cuenten con documentación clara, explicaciones técnicamente válidas y significativas, así como notificaciones comprensibles y accesibles. Para facilitar su aplicación, este marco se complementa con una guía práctica titulada From Principles to Practice, que orienta sobre cómo implementar estos principios en contextos reales.

Además, otras agencias federales han comenzado a exigir niveles concretos de explicabilidad en el uso de herramientas de IA. La Equal Employment Opportunity Commission (EEOC), por ejemplo, ha establecido que los sistemas utilizados para la contratación y evaluación de personal deben ser comprensibles y transparentes, con el fin de evitar discriminación y promover la equidad en los procesos laborales. Por su parte, el NIST AI Risk Management Framework, publicado en 2023, proporciona directrices voluntarias para desarrollar sistemas de IA confiables. Este marco incluye secciones específicas dedicadas a la explicabilidad como uno de los pilares fundamentales para gestionar los riesgos asociados al uso de estas tecnologías.

En el ámbito internacional, los Principios de la OCDE sobre Inteligencia Artificial, adoptados en 2019 por los 38 países miembros, también refuerzan la necesidad de una IA que sea confiable y respetuosa con los derechos humanos y los valores democráticos. Entre sus recomendaciones se encuentra la transparencia y la divulgación responsable, con el objetivo de que las personas afectadas por un sistema de IA puedan entender cómo se han producido los resultados que les conciernen. En conjunto, estas regulaciones están impulsando a las organizaciones a invertir en tecnologías de IA explicable desde las primeras fases de diseño de los modelos, asegurando así que sean no solo eficientes, sino también comprensibles y responsables.

En Europa, el marco normativo sobre inteligencia artificial ha sido liderado por el Reglamento General de Protección de Datos, que entró en vigor en 2018. Este reglamento reconoce el “derecho a una explicación”, lo que implica que los ciudadanos pueden exigir a las empresas una justificación comprensible sobre por qué un sistema de IA ha producido un determinado resultado. Este principio tiene implicaciones críticas en el diseño, desarrollo y análisis de modelos interpretables, obligando a las compañías a asegurar la transparencia algorítmica desde la fase de concepción de sus modelos.

Un paso aún más ambicioso ha sido la aprobación del Artificial Intelligence Act (AI Act) en 2024, el primer marco legal integral sobre IA en el mundo, con aplicación progresiva hasta 2026. Esta ley establece una clasificación de los sistemas de IA en función de su nivel de riesgo (riesgo inaceptable, alto, limitado o mínimo) y regula con mayor severidad aquellos considerados de alto riesgo. En estos casos, se exige el cumplimiento de condiciones como:

El AI Act impone requisitos estrictos sobre la interpretabilidad de los modelos de IA, lo cual está generando una ola de iniciativas para adaptar los sistemas existentes. Estas adaptaciones incluyen documentación técnica exhaustiva, uso de técnicas de interpretabilidad, implementación de cuadros de mando de seguimiento, sistemas de alerta, y la revisión integral de los procedimientos de diseño, validación, implementación y uso de los modelos.

En esta línea, la Comisión Europea también publicó en 2019 las Directrices Éticas para una Inteligencia Artificial Fiable, que identifican siete requisitos clave para una IA considerada confiable:

Dentro del principio de transparencia, se incluye explícitamente la necesidad de explicabilidad de los sistemas de IA. Estas directrices no solo fijan los principios, sino que proponen criterios de evaluación adaptables a cada caso, estableciendo además la necesidad de clasificar los modelos según su riesgo y grado de interpretabilidad, para determinar el nivel de exigencia requerido.

Por último, en el sector financiero, la Autoridad Bancaria Europea (EBA) publicó en noviembre de 2021 el informe Discussion Paper on Machine Learning for IRB Models, centrado en el uso de IA en el cálculo del capital regulatorio bajo el enfoque IRB. Este documento desciende a un nivel más técnico que otras regulaciones y recomienda a las entidades financieras encontrar un equilibrio entre complejidad e interpretabilidad. Entre sus propuestas destaca la obligación de analizar estadísticamente los modelos, presentar un documento de síntesis comprensible, y garantizar la detección de posibles sesgos, lo que refuerza aún más la necesidad de explicabilidad en sectores altamente regulados.[4]

España se anticipó al AI Act con su Estrategia Nacional de IA (ENIA) y un sandbox regulatorio coordinado por la Agencia Española de Protección de Datos (AEPD) y la Secretaría de Estado de Digitalización. La AEPD publicó en 2021, una guía sobre tratamientos algorítmicos, que aclara que los ciudadanos tienen derecho a conocer la lógica utilizada y a impugnar decisiones automáticas. Además, la AEPD interpreta del artículo 22 de la GRPD, que las organizaciones están obligadas a proporcionar explicaciones significativas sobre decisiones automatizadas.

La XAI, por tanto, se está posicionando como una disciplina de relevancia creciente, lo que está llevando a reguladores y supervisores de distintas jurisdicciones a establecer reglamentos y directrices para el uso apropiado de la AI y su funcionamiento.

La inteligencia artificial explicable engloba un conjunto de procesos y métodos que permiten a los usuarios entender y confiar en los resultados y productos generados por algoritmos de aprendizaje automático. El objetivo de la XAI es lograr que la IA no sea una “caja negra”; es decir, un sistema donde solo vemos los resultados pero no entendemos cómo se han generado, sino algo más transparente y comprensible para los humanos. Para empezar a abordar la XAI, es importante entender estos tres principios clave:

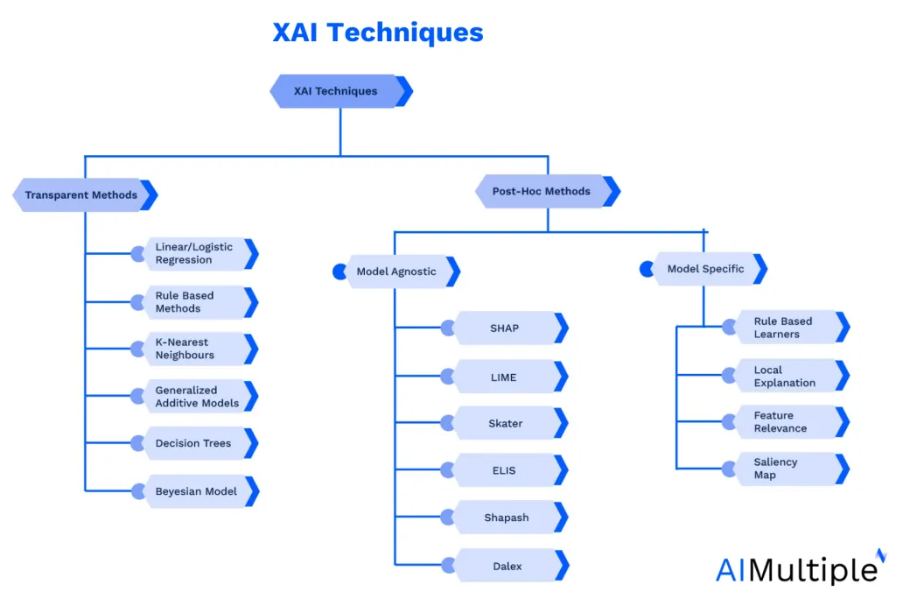

Fuente: AI Multiple Research

Los modelos white box son algoritmos diseñados desde su origen para ser interpretables. Se caracterizan por ser simples, transparentes y fácilmente implementables. Sus algoritmos consisten en cálculos sencillos que incluso pueden ser realizados por humanos, lo que permite comprender de manera clara cómo se llega a una decisión específica. Esta capacidad de explicación directa convierte a estos modelos en herramientas valiosas para tareas que requieren alta interpretabilidad.

Entre los algoritmos que se explican por sí mismos destacan los árboles de decisión, la regresión lineal y la regresión logística. Aunque ofrecen una comprensión directa del modelo y de sus resultados, suelen presentar una menor precisión predictiva en comparación con modelos más complejos como las redes neuronales.[5]

Estos modelos suelen limitar el número de parámetros a optimizar para facilitar su comprensión, lo que redunda en decisiones más informadas. Se agrupan principalmente en cuatro categorías:

Además, diversos estudios han propuesto características clave que deben cumplir estos modelos para maximizar su interpretabilidad:

Estos enfoques permiten explicar de forma comprensible la lógica del modelo y su proceso de decisión, aunque su aplicación a problemas complejos puede verse limitada por su simplicidad inherente.

Esta limitación ha impulsado la investigación de nuevos modelos autoexplicativos que mejoren la precisión sin sacrificar interpretabilidad. Un avance importante en este ámbito son los Modelos Aditivos Generalizados (GA2M), que permiten introducir comportamiento no lineal en los parámetros, superando el alto sesgo de la regresión lineal y logística. Estos modelos conservan la interpretabilidad al mismo tiempo que incrementan su capacidad predictiva.

Los modelos complejos como las Redes Neuronales Artificiales (RNA) o los bosques aleatorios presentan grandes retos en cuanto a interpretabilidad. A estos se les denomina modelos de caja negra, debido a la opacidad de su funcionamiento interno y la dificultad de comprender las relaciones entre sus entradas y predicciones. Sin embargo, son ampliamente utilizados por las empresas por su elevado rendimiento.[6]

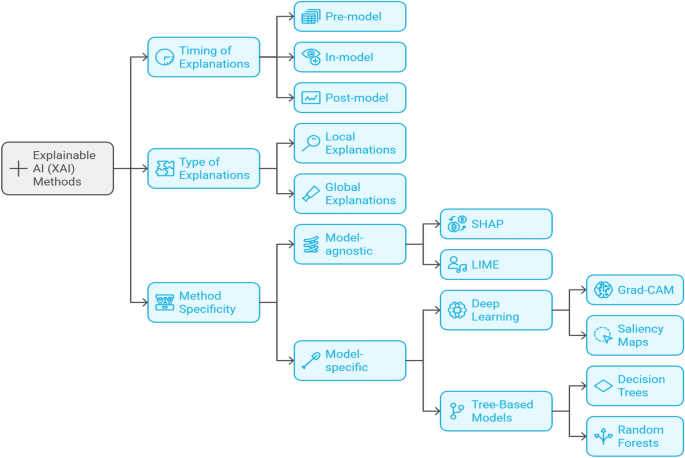

Para explicar estos modelos sin modificar su estructura, se recurre a técnicas post-hoc que actúan como interfaces interpretables. Estas técnicas permiten visualizar el comportamiento del modelo y entender cómo diferentes variables afectan las predicciones. Estas se suelen dividir en técnicas de interpretabilidad global y local, en referencia a si la técnica explica todo el modelo en conjunto o únicamente los resultados en un subconjunto de observaciones o datos. Además, dentro de las explicaciones locales, están las explicaciones contrafactuales describen escenarios hipotéticos o lo que el modelo habría predicho con diferentes entradas.

También se pueden clasificar según el momento en el que se aplican:

Los métodos de explicación son otra forma de difernciar entre las técnicas post-hoc: los que se pueden aplicar a cualquier algoritmo (como LIME o SHAP) son llamados métodos agnósticos, mientras que existen otros métodos que están pensados específicamente para ciertos algoritmos[7] como por ejemplo:

Los enfoques híbridos combinan las fortalezas de las técnicas específicas y agnósticas del modelo para mejorar la interpretabilidad y la aplicabilidad.

Existen diversas técnicas post-hoc ampliamente utilizadas para mejorar la comprensión de los modelos de inteligencia artificial una vez entrenados. A continuación, se destacan las más empleadas:

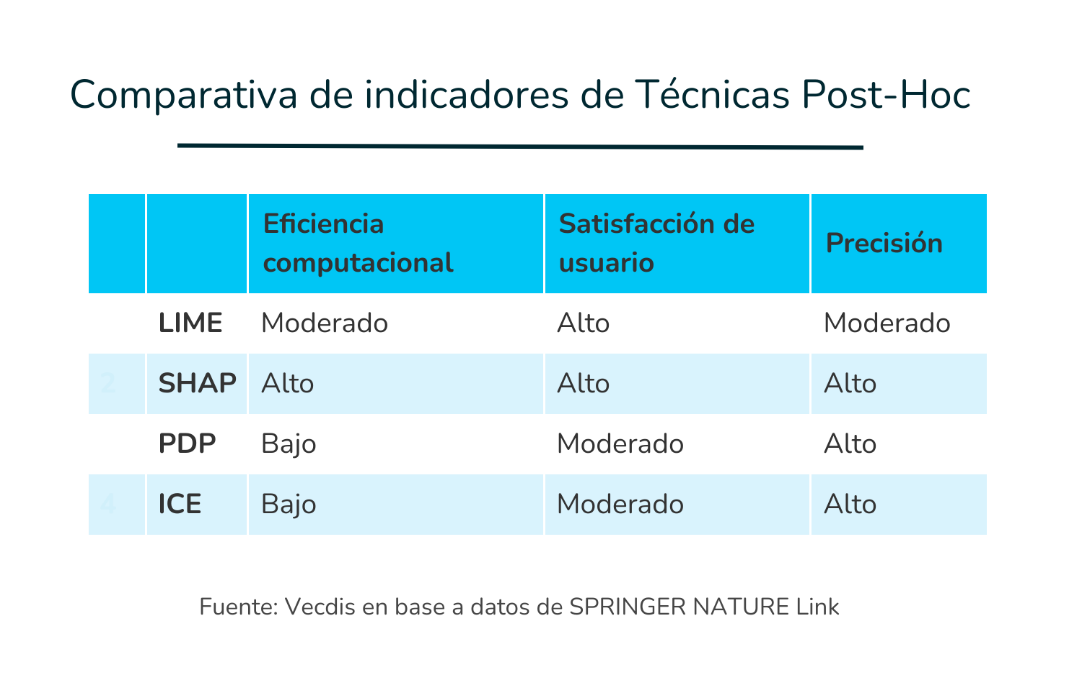

Fuente: SPRINGER NATURE Link

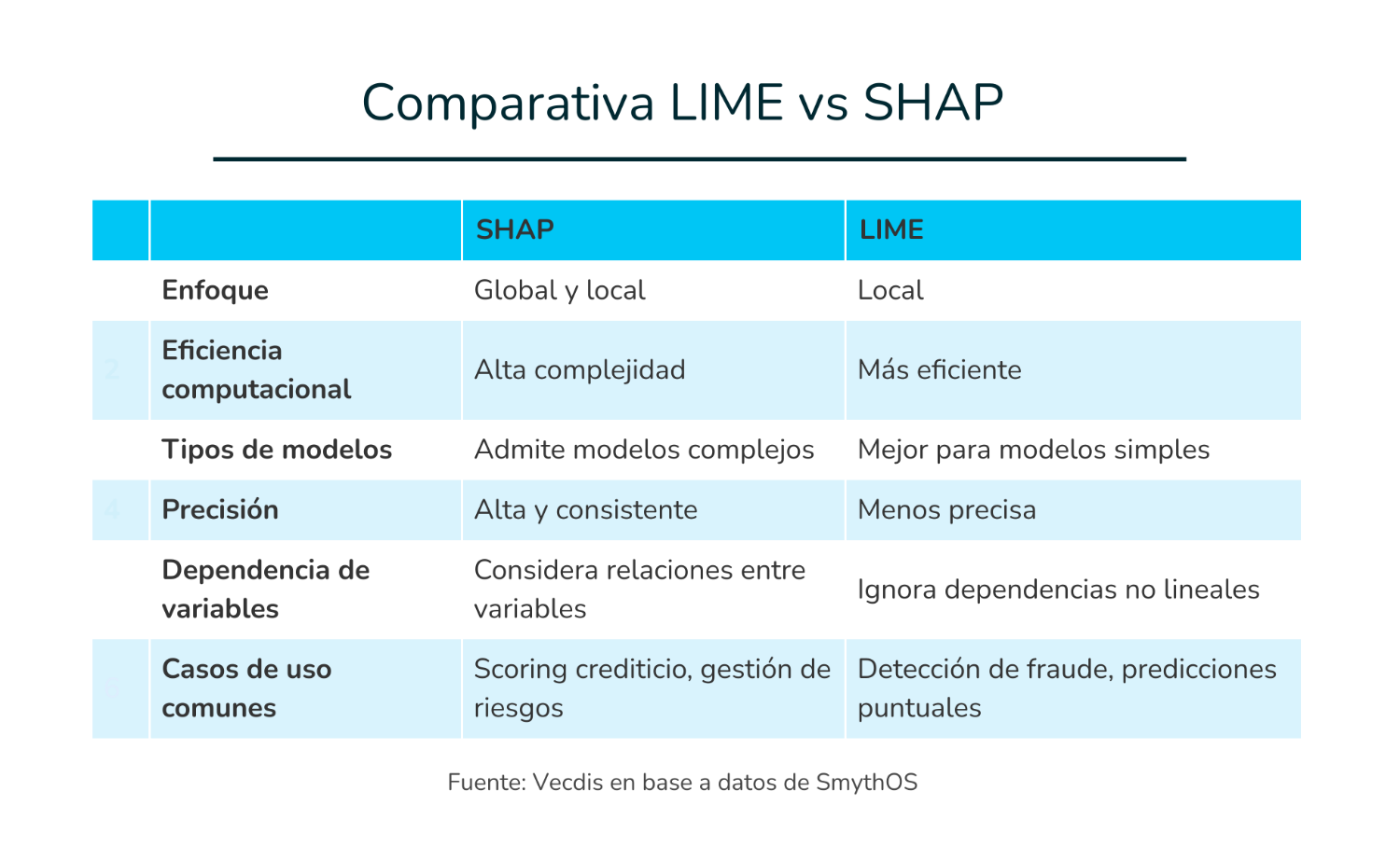

Los dos métodos más utilizados para proporcionar explicaciones locales son LIME y SHAP. LIME construye modelos interpretables para predicciones particulares, mientras que SHAP proporciona una medida consistente de la contribución a la importancia de las características.[8]

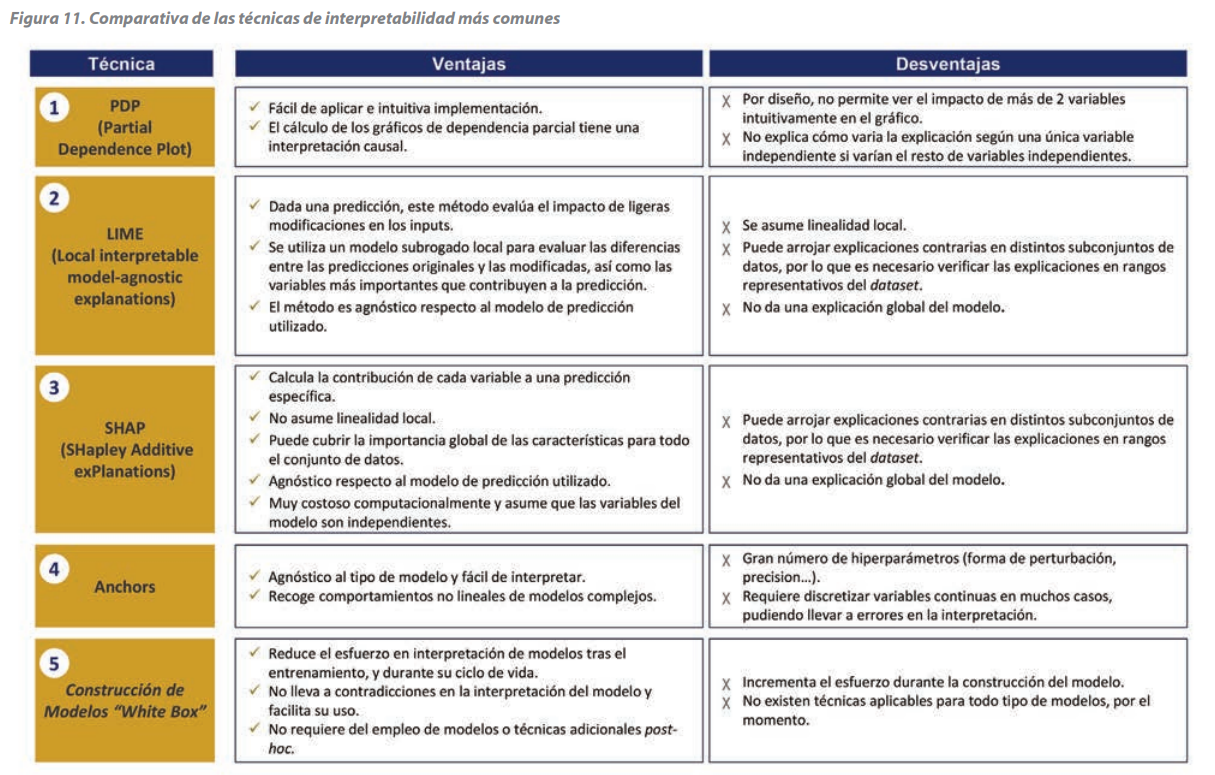

Después de estudiar los diferentes enfoques de XAI, analizaremos comparativamente varios enfoques de XAI en indicadores clave de rendimiento como la eficiencia computacional, la satisfacción del usuario y la precisión. Esta comparación permite evaluar qué técnica se adapta mejor a las necesidades específicas de la organización o sector.[7]

No existe una única técnica que ofrezca explicaciones completas, globales e intuitivas en todos los escenarios. Por ello, se recomienda combinar varias técnicas para asegurar resultados consistentes y aplicables a distintos contextos.

A pesar de los avances, todavía existen obstáculos transversales a todas las técnicas:

Por otro lado, cada técnica presenta ventajas y desventajas, que son importantes tomar en cuenta al momento de seleccionar con cuál trabajar.

Fuente: Management Solutions

La XAI, por tanto, se ocupa tanto de las técnicas para intentar explicar el comportamiento de determinados modelos opacos (black box) como del diseño de algoritmos inherentemente interpretables (white box), explicando cómo los modelos extraen conclusiones específicas y cuáles son las fortalezas y debilidades del algoritmo. En ese sentido, XAI amplía la interpretabilidad de cualquier modelo de IA y ayuda a los humanos a comprender las razones de sus decisiones.

Para reducir la brecha entre la teoría y la práctica, la Inteligencia Artificial Explicable ha demostrado un valor tangible en múltiples sectores. Su implementación en el mundo real ofrece a las partes interesadas más que promesas teóricas: proporciona evidencia concreta de su utilidad, aumentando la confianza, la responsabilidad y la comprensión en el uso de modelos de IA.

A continuación, se presentan estudios de casos clave que ilustran los logros y desafíos de XAI.

La XAI está transformando el ámbito de la salud, donde su capacidad para hacer comprensibles las decisiones de los modelos de IA ha sido crucial para mejorar la precisión diagnóstica y, la transparencia y la confianza entre doctores y pacientes.

En el diagnóstico médico y análisis de imágenes, la XAI permite que los modelos de IA expliquen cómo llegan a ciertas conclusiones al analizar síntomas, resultados de laboratorio e imágenes médicas. Por ejemplo, al examinar radiografías de tórax, puede destacar áreas sospechosas y justificar un diagnóstico, como el de neumonía. Esta capacidad resulta especialmente relevante en oncología, donde empresas líderes han implementado XAI para detectar patrones sutiles en resonancias magnéticas y tomografías, proporcionando a los radiólogos visualizaciones detalladas y explicaciones claras sobre las anomalías encontradas.

Asimismo, la XAI se está aplicando en sistemas de apoyo a la toma de decisiones clínicas para justificar tratamientos específicos basados en el historial médico, lo que contribuye a reducir errores y permite decisiones más informadas. En el ámbito de la predicción de resultados, la IA analiza datos históricos y patrones de recuperación para prever la respuesta de los pacientes a determinados tratamientos, ofreciendo explicaciones claras y clínicamente relevantes que respaldan la elección terapéutica.

Esta tecnología ofrece beneficios tanto a profesionales como a pacientes. Por un lado, mejora la curva de aprendizaje de nuevos radiólogos y permite a los médicos revisar los factores que contribuyen a un diagnóstico. Por otro, brinda a los pacientes explicaciones comprensibles sobre sus condiciones, lo que incrementa la confianza, mejora el cumplimiento del tratamiento y fortalece la colaboración entre IA y profesionales de la salud.

En el sector financiero, la XAI aporta un valor estratégico al hacer comprensibles los modelos de inteligencia artificial utilizados en calificación crediticia, evaluación de riesgos y detección de fraudes. Esta capacidad es fundamental para garantizar el cumplimiento normativo y consolidar la confianza del consumidor, en un entorno donde las decisiones automatizadas tienen un impacto directo sobre las personas. Por ejemplo, un banco global utiliza esta tecnología para mostrar cómo variables como la estabilidad laboral o el historial de pagos influyen en la aprobación de préstamos. Esto no solo mejora la comprensión del cliente, sino que también refuerza la equidad en los procesos de evaluación, generando una relación más transparente entre entidades y usuarios.

En el ámbito de la detección de fraudes, empresas como American Express aplican modelos habilitados para XAI que analizan más de 1 billón de dólares en transacciones al año. Gracias a esta tecnología, los analistas pueden identificar patrones sospechosos con razonamientos comprensibles, lo que permite una intervención más rápida y precisa. A su vez, esto refuerza las políticas de gestión de riesgos y mejora la protección frente a amenazas emergentes.

XAI también facilita el cumplimiento de regulaciones como el Reglamento General de Protección de Datos, al proporcionar explicaciones claras de decisiones automatizadas que antes eran opacas. En el proceso de evaluación de préstamos, se han aplicado técnicas como PDP y SHAP. Mientras los PDP permiten visualizar el impacto global de variables como la tasa de interés o los años de empleo, SHAP ofrece explicaciones individualizadas para cada solicitante, lo que permite entender con mayor precisión cómo cada característica influye en el resultado final. Esto repercute directamente en una mejor experiencia del cliente, ya que los usuarios reciben recomendaciones justificadas sobre cómo mejorar su perfil financiero, mientras que los bancos pueden comparar modelos, optimizar estrategias y reducir la probabilidad de decisiones erróneas o injustas.

Los vehículos autónomos constituyen una de las aplicaciones más avanzadas de la inteligencia artificial, y en este contexto, la XAI desempeña un papel crucial tanto en la seguridad operativa como en la aprobación normativa. Las principales empresas automotrices están incorporando XAI para transparentar los procesos de toma de decisiones en situaciones críticas, como la detección de obstáculos repentinos o la reacción ante movimientos inesperados de peatones, aspectos esenciales para garantizar un comportamiento seguro en entornos dinámicos.

El uso de XAI permite que ingenieros y reguladores comprendan y validen las decisiones de los sistemas de conducción autónoma bajo diversas condiciones. Al mismo tiempo, ofrece a los pasajeros y al público general explicaciones comprensibles sobre el comportamiento del vehículo, como por qué se realizó una maniobra evasiva. Esta transparencia es clave para aumentar la confianza del usuario y acelerar la aceptación social de esta tecnología. Además, la XAI aporta un valor añadido en los marcos legales, al generar rutas de decisión trazables que permiten determinar responsabilidades en caso de incidentes o accidentes.

Gracias a la XAI, los vehículos autónomos pueden justificar su comportamiento en tiempo real, imitando el razonamiento de un conductor humano. Por ejemplo, si el vehículo frena bruscamente o cambia de carril, puede explicar que detectó un coche desacelerando peligrosamente. Este tipo de explicaciones en tiempo real fortalece la confianza de los ocupantes y permite mejorar continuamente los algoritmos a través de análisis posteriores.

Finalmente, la XAI refuerza la trazabilidad y la responsabilidad mediante modelos que analizan datos de accidentes, como el uso de SHAP para clasificar la gravedad de lesiones y evaluar riesgos. Esto resulta beneficioso tanto para compañías de seguros como para autoridades reguladoras, al proporcionar evidencia clara y evaluaciones precisas.

La XAI está transformando el sector del transporte y la logística al proporcionar información transparente y respaldar la toma de decisiones basadas en datos. Más allá de su rol en vehículos autónomos, XAI tiene un impacto significativo en la optimización de procesos logísticos, permitiendo mejorar la eficiencia operativa, reducir costos y contribuir a la sostenibilidad ambiental en toda la cadena de suministro.

Entre las aplicaciones más relevantes, XAI permite la planificación y optimización de rutas, analizando datos históricos, patrones de tráfico y restricciones operativas para recomendar trayectos más eficientes, lo que se traduce en menores tiempos de entrega y reducción de costos. Asimismo, apoya la previsión de la demanda al evaluar tendencias de mercado y comportamientos del consumidor, facilitando una gestión del inventario más ajustada a la realidad y evitando tanto el exceso como la escasez de productos.

Otro ámbito clave es la optimización de la carga, donde XAI emplea algoritmos predictivos para maximizar la utilización del espacio en los vehículos, reducir trayectos vacíos, minimizar el consumo de combustible y aumentar la rentabilidad general. En paralelo, el seguimiento en tiempo real de envíos y vehículos se ve potenciado con explicaciones claras de los eventos logísticos, lo que permite tomar decisiones proactivas ante interrupciones o retrasos.

Finalmente, la IA explicable también tiene un papel destacado en la sostenibilidad ambiental, ya que facilita la reducción de la huella de carbono mediante un uso más eficiente de los recursos energéticos y la planificación inteligente de rutas. En conjunto, XAI empodera al sector logístico con decisiones explicables, visualización clara de resultados y una mayor transparencia operativa, favoreciendo tanto la eficiencia económica como el compromiso ambiental.

En el sector del comercio minorista y el comercio electrónico, la XAI está emergiendo como una herramienta fundamental para mejorar la confianza, precisión y ética en múltiples aplicaciones. Desde la personalización de recomendaciones hasta la detección de fraudes, la explicabilidad se vuelve clave para equilibrar el rendimiento de los sistemas de IA con la protección de la privacidad del usuario.

Entre las aplicaciones más destacadas de XAI en comercio electrónico, se encuentran las recomendaciones personalizadas, que utilizan el historial de compras y navegación para ofrecer sugerencias más relevantes y valiosas. Además, la gestión predictiva de inventario supera los métodos tradicionales al incorporar pronósticos de demanda y alertas sobre posibles problemas en la cadena de suministro. La atención al cliente automatizada también se beneficia, ya que XAI mejora la eficiencia y precisión de chatbots y asistentes virtuales, ofreciendo soporte continuo con respuestas explicables. Por último, la detección de fraudes y falsificaciones se fortalece al identificar patrones sospechosos mediante criterios interpretables, aumentando la seguridad de las plataformas.

En ese sentido, la XAI facilita que los minoristas optimicen sus operaciones, tomen decisiones informadas, mejoren la personalización sin comprometer la privacidad, aumenten las tasas de conversión, reduzcan el abandono de carritos y eleven el valor promedio de los pedidos. Todo ello con ele objetivo de ofrecer una experiencia de usuario más ética, transparente y rentable, fomentando la confianza del consumidor y la eficiencia operativa.

La XAI juega un papel fundamental en la agricultura al permitir que agricultores, agrónomos y responsables políticos comprendan y confíen en las decisiones impulsadas por la IA.

Gracias a la XAI, mediante gráficos y visualizaciones intuitivas, los agricultores pueden explorar qué cultivos se adaptan mejor a diferentes condiciones y comprender la lógica detrás de cada predicción, facilitando la toma de decisiones en contextos complejos y variables.

La XAI también contribuye a la predicción climática y a las decisiones relacionadas con el cultivo, anticipando momentos óptimos para sembrar, cosechar o vender productos agrícolas. Utilizando modelos de aprendizaje automático que analizan patrones climáticos, condiciones del suelo y otros factores ambientales, esta tecnología promueve una gestión más resiliente y sostenible, mejorando los rendimientos y minimizando el desperdicio de recursos.

En la agricultura de precisión, la XAI proporciona información detallada sobre niveles de humedad, salud del suelo y estado de los cultivos, permitiendo intervenciones específicas como riego o fertilización dirigida. Esto optimiza el uso de insumos agrícolas y aumenta la eficiencia operativa en el campo. Asimismo, facilita la detección temprana de enfermedades y plagas mediante algoritmos de aprendizaje automático, lo que permite acciones proactivas para controlar infestaciones y rotar cultivos, contribuyendo a la seguridad alimentaria.

La predicción de cosechas y rendimiento es otra aplicación clave, donde la XAI analiza datos históricos, niveles de madurez y factores ambientales para pronosticar tiempos óptimos de cosecha, maximizando la productividad y reduciendo desperdicios. Esto ayuda a los agricultores a planificar mejor sus recursos y logística. Finalmente, en el mejoramiento genético y fenotipado, la XAI optimiza la selección asistida por marcadores, identificando rasgos genéticos deseados de manera más eficiente y combinándose con tecnologías avanzadas como el fenotipado remoto mediante drones, superando limitaciones en el estudio de rasgos complejos como la tolerancia a la sequía.

La XAI tiene un gran potencial para transformar la educación al permitir la personalización del aprendizaje, adaptando el contenido y el ritmo de instrucción a las necesidades individuales de cada estudiante. Esto genera experiencias educativas personalizadas que mejoran significativamente los resultados académicos.

En los procesos de evaluación, la XAI ofrece criterios de calificación transparentes y métricas objetivas de rendimiento, lo que posibilita una evaluación más justa y la entrega de retroalimentación constructiva por parte de los educadores. Además, proporciona herramientas para el análisis del aprendizaje mediante el estudio de datos estudiantiles, permitiendo identificar patrones, tendencias y áreas de mejora. Esto facilita la planificación instruccional basada en datos, favoreciendo intervenciones educativas más precisas y oportunas.

La optimización de recursos es otro beneficio clave, ya que la XAI analiza las necesidades y el desempeño de los estudiantes para asignar de manera eficiente el personal, la tecnología y los materiales educativos, asegurando un acceso equitativo y efectivo. Al mismo tiempo, la transparencia en las decisiones tomadas por los sistemas de IA promueve la confianza institucional, reforzando la rendición de cuentas y ganándose la confianza de alumnos, familias y profesionales.

Combinada con técnicas avanzadas como el aprendizaje federado (FL) y la fusión multimodal, la XAI contribuye a eliminar modelos de baja calidad sin necesidad de compartir datos sensibles, lo cual es fundamental para entornos educativos virtuales centrados en el ser humano. Asimismo, la XAI facilita la participación de las familias, ofreciendo explicaciones comprensibles sobre el progreso académico y las decisiones educativas, fortaleciendo así el entorno de apoyo al estudiante.

La XAI se ha convertido en una herramienta esencial en contextos legales y regulatorios al permitir justificar decisiones automatizadas, garantizando así el cumplimiento de normas éticas y legales, como el Reglamento General de Protección de Datos. Gracias a esta capacidad, los reguladores pueden identificar sesgos o prácticas discriminatorias en áreas sensibles.

En el ámbito de la vigilancia policial, la IA se utiliza para optimizar la asignación de recursos a través de predicciones, pero la XAI es fundamental para asegurar la rendición de cuentas y evitar que los algoritmos refuercen sesgos contra comunidades vulnerables. De igual modo, en el análisis legal, la XAI permite comprender cómo los modelos de IA evalúan riesgos legales en contratos, facilitando que los profesionales jurídicos tomen decisiones más informadas.

Sin embargo, el uso de XAI aún enfrenta retos significativos en cuanto a requisitos legales específicos. Muchos métodos actuales no cumplen adecuadamente con estándares como la fidelidad y la estimación de confianza, especialmente tras la aprobación de la nueva Ley de IA del Parlamento Europeo en 2024. Cada área legal requiere diferentes propiedades explicativas, lo que representa un desafío de implementación para todo el entorno regulatorio.

Finalmente, en el sector de la administración tributaria, muchas agencias fiscales están implementando sistemas de IA para automatizar procesos, lo que podría poner en riesgo los derechos de los contribuyentes. Se advierte que los marcos jurídicos actuales no cubren adecuadamente las exigencias informativas del ámbito tributario, por lo que identifican desafíos técnicos y legales clave para una implementación verdaderamente efectiva y justa.

La explicabilidad en el PLN permite entender por qué un texto es interpretado de cierta manera, lo cual es especialmente útil en el análisis de sentimientos, donde se puede identificar qué palabras generaron una emoción positiva o negativa. Asimismo, los chatbots explicables generan mayor confianza al ofrecer respuestas fundamentadas, mejorando la interacción y satisfacción del usuario.

En la gestión del talento, la IA explicable es clave para asegurar procesos justos y transparentes, especialmente en la selección de candidatos, donde puede justificar las decisiones sin comprometer la privacidad del modelo. Además, en la predicción del rendimiento, ofrece a los gerentes una base clara y confiable para tomar decisiones, fortaleciendo la objetividad en la evaluación de los empleados.

La XAI mejora la eficiencia del sistema judicial al aplicarse en tareas como el análisis de ADN, predicción de delitos o evaluación de riesgos penales, acelerando decisiones y reduciendo sesgos. Su capacidad para explicar los razonamientos detrás de las predicciones permite una mayor transparencia y equidad en procedimientos críticos, ayudando a evitar discriminaciones y errores judiciales.

En ciberseguridad, la IA explicable refuerza la detección de amenazas y respuesta a incidentes, ya que permite a los analistas comprender por qué se genera una alerta. Esta claridad no solo mejora la reacción ante ataques, sino que también contribuye a diseñar sistemas más seguros, fiables y adaptados a contextos donde la confianza en la tecnología es esencial.

La inteligencia artificial explicable se ha consolidado como un elemento estratégico para el desarrollo responsable y eficiente de soluciones basadas en IA. Su capacidad para aportar transparencia y comprensión a modelos cada vez más complejos resulta clave en sectores donde la confianza, la trazabilidad y el cumplimiento normativo son esenciales. Lejos de ser un lujo técnico, la explicabilidad se ha convertido en una necesidad operativa y ética para cualquier organización que aspire a escalar el uso de la IA de manera sostenible.

La creciente regulación internacional y las demandas de usuarios, clientes y auditores exigen que las organizaciones adopten mecanismos de gobernanza sobre sus sistemas de IA. Esto implica no solo garantizar la calidad y trazabilidad de los modelos, sino también demostrar de forma clara cómo y por qué una IA toma una determinada decisión.

Para lograrlo, combina enfoques de white-box, donde el funcionamiento interno del algoritmo es comprensible desde el diseño, con modelos de caja negra, que requieren técnicas post-hoc como SHAP, LIME o visualizaciones de relevancia para generar explicaciones. Esta integración permite que incluso modelos complejos como redes neuronales profundas sean auditables, lo que fortalece la confianza social, el cumplimiento normativo y la toma de decisiones éticas basadas en IA.

La XAI impulsa una adopción más transparente, responsable y confiable de la IA, especialmente en contextos sensibles como la salud, la educación, la agricultura o las finanzas. Se destacan aplicaciones como en la salud, donde permite entender decisiones clínicas complejas; en las finanzas, al hacer comprensibles los criterios de riesgo o crédito; y en la agricultura, al optimizar cultivos con base en datos climáticos o del suelo.

Integrar la XAI no es únicamente una cuestión tecnológica, sino organizacional. Requiere desarrollar un marco integral que combine soluciones técnicas, un sólido gobierno del modelo, talento capacitado y una cultura interna basada en la transparencia. Solo así es posible convertir la explicabilidad en una ventaja competitiva que empodere a los equipos, mejore la interacción con usuarios finales y aumente la eficiencia en el uso de la inteligencia artificial.

En definitiva, la XAI permite desbloquear el verdadero valor de la IA al dotarla de comprensibilidad, confianza y responsabilidad. Su implementación progresiva garantizará no solo el cumplimiento normativo, sino también una mayor aceptación social y operativa de la IA en contextos sensibles, desde la salud hasta las finanzas. Las organizaciones que integren la explicabilidad como un eje transversal de sus procesos de IA estarán mejor posicionadas para aprovechar todo su potencial sin renunciar a la transparencia ni a los principios éticos.

[1] DIGITALDEFYND. Evolution of Explainable AI (XAI). [Consultado: 24-06-2025]. Disponible en: https://digitaldefynd.com/IQ/evolution-of-explainable-ai-xai/

[2] MARKETS AND MARKETS. Explainable AI Market. Noviembre del 2023. [Consultado: 24-06-2025]. Disponible en: https://www.marketsandmarkets.com/Market-Reports/explainable-ai-market-47650132.html

[3] GRAND VIEW RESEARCH. Explainable AI Market Size, Share & Trends Analysis Report. [Consultado: 24-06-2025]. Disponible en: https://www.grandviewresearch.com/industry-analysis/explainable-ai-market-report

[4] MANAGEMENT SOLUTIONS. Explainable artificial intelligence (XAI): Desafíos en la interpretabilidad de los modelos. [Consultado: 24-06-2025]. Disponible en: https://www.managementsolutions.com/sites/default/files/minisite/static/22959b0f-b3da-47c8-9d5c-80ec3216552b/iax/pdf/explainable-artificial-intelligence-sp.pdf

[5] DELOITTE. Bringing Transparency to Machine Learning Models & Predictions. [Consultado: 24-06-2025]. Disponible en: https://www.deloitte.com/content/dam/assets-zone2/de/de/docs/issues/innowation-ai/2024/Deloitte_Trustworthy%20AI%20Whitepaper_2021-2.pdf

[6] AI MULTIPLE RESEARCH. Explainable AI (XAI) in 2025: Guide to enterprise-ready AI. Junio del 2025. [Consultado: 24-06-2025]. Disponible en: https://research.aimultiple.com/xai/

[7] SPRINGER NATURE LINK. Transformative impact of explainable artificial intelligence: bridging complexity and trust. Mayo del 2025. [Consultado: 24-06-2025]. Disponible en: https://link.springer.com/article/10.1007/s44163-025-00281-1

[8] SMYTHOS. Top Use Cases of Explainable AI: Real-World Applications for Transparency and Trust. [Consultado: 24-06-2025]. Disponible en: https://smythos.com/developers/agent-development/explainable-ai-use-cases/